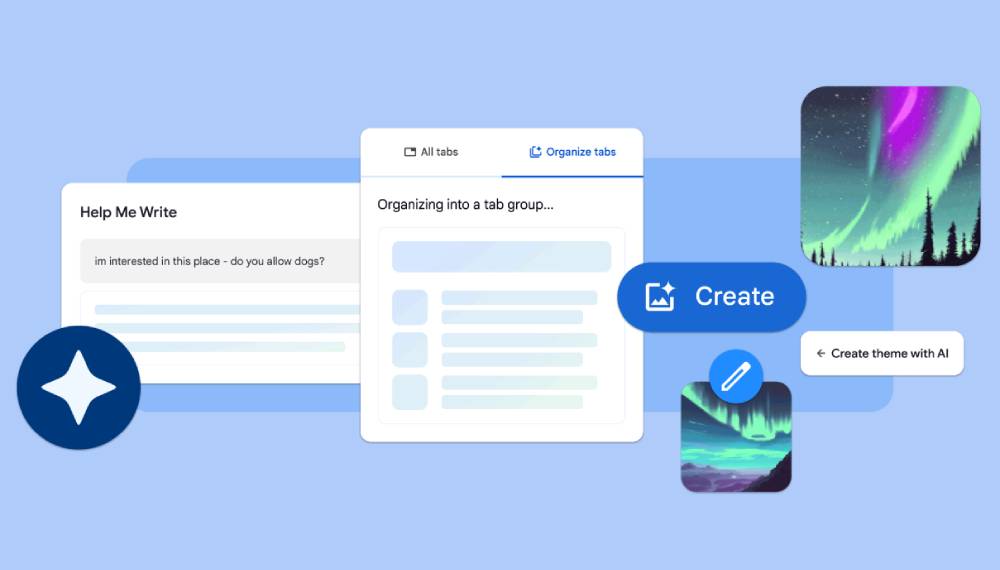

Google Gemma是什么,如何使用?

Google Gemma是什么?

Google Gemma 是由 Google DeepMind 和 Google 其他团队开发的一系列轻量级、先进的开放模型,对标另一个ai模型:Llama,Gemma这个名字来源于拉丁语中的“宝石”,灵感来自该公司更大、功能更强大的 AI 模型 Gemini,Gemma将向全球用户提供两种规模版本:2B(20亿参数)和7B(70亿参数),能够支持各种工具和系统,同时能在开发者的笔记本电脑及工作站上顺畅运行。

与 Gemma 一起,Google 还发布了一个新的生成式AI工具包,为使用 Gemma 创建更安全的 AI 应用程序提供指导和基本工具。

要想体验Gemma,最方便直观用 LM Studio。使用地址:https://lmstudio.ai,点击下载模型,自带GUI对话界面。

Google Gemma功能特征:

技术背景:Gemma 建立在用于创建 Gemini 模型的相同研究和技术之上,利用相同的基础设施组件。

型号尺寸:发布了两种尺寸的 Gemma 型号:Gemma 2B 和 Gemma 7B,每种型号都配备了预训练和指令调整的变体。

性能:尽管重量轻,但 Gemma 型号提供了最先进的性能,超出了对其尺寸的预期,并遵守了 Google 关于安全和负责任输出的严格标准。

责任:谷歌强调负责任地使用人工智能,采用自动化技术从训练集中过滤掉敏感数据,并采用广泛的微调和强化学习方法。

可访问性:Gemma 型号在全球范围内可用,并附带支持开发人员创新、促进协作和指导负责任使用的工具。

硬件兼容性:这些模型经过优化,可在各种 AI 硬件平台上运行,确保在部署在 Google Cloud 的 TPU 或 NVIDIA GPU 上时具有行业领先的性能。

Google Gemma如何使用?

为了有效地使用Google Gemma,建议遵循以下步骤:

1、深入了解 Gemma 模型及其规格

熟悉 Gemma 的不同版本,例如 Gemma 2B 和 Gemma 7B。

掌握各型号的预训练和指令调整变体,以及它们的适用场景。

2、探索支持工具和框架

了解 Google 提供的工具,这些工具旨在支持 Gemma 模型的创新使用和负责任使用。

熟悉跨 JAX、PyTorch 和 TensorFlow 等主流框架的工具链,以便于进行模型推理和监督微调。

3、评估实际应用和性能

通过研究技术报告和实际应用案例,了解 Gemma 模型在实际环境中的表现。

查阅 Gemma 模型在 MMLU 语言理解基准和 HumanEval 编程挑战等基准测试中的表现。

4、确保负责任使用和遵守道德规范

了解集成到 Gemma 中的 AI 原则,以及为保证模型输出的安全性和负责任性所做的努力。

利用 Google 提供的负责任生成式 AI 工具包,指导模型的负责任使用。

5、掌握技术细节和硬件兼容性

深入了解 Gemma 模型的技术细节,包括在不同 AI 硬件平台上的优化策略。

了解模型的使用条款,包括允许的商业用途和分发政策。

6、实践教程和示例

通过 Keras NLP 指南中提供的动手教程和示例,开始实践使用 Gemma。

探索如何使用 LoRA API 和多 GPU/TPU 来微调 Gemma 模型。

7、实现与外部平台的集成

探索将 Gemma 与外部平台和工具(如 Hugging Face、MaxText 和 TensorRT-LLM)的集成方法。

8、探索部署选项

根据项目需求,选择在本地机器、Google Cloud(包括 Vertex AI 和 Google Kubernetes Engine)或通过参加 Kaggle 和 Colab 竞赛来部署 Gemma 模型。

其他资源

访问Google Gemma GitHub 库或者通过访问 ai.google.dev/gemma,获取更多关于Google Gemma及其开发的信息并获取快速入门指南。

根据以上步骤,您可以有效地整合 Google Gemma 模型到您的项目中。

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统