Open-Sora 1.1发布:视频生成质量和持续时间显著提升

今天,我们很高兴地推出 Open-Sora-Plan v1.1.0,它显着提高了视频生成质量和持续时间以及文本控制功能。与之前的 Open-Sora-Plan v1.1.0 版本相比,改进了:

更好的压缩视觉表示:我们优化了 CausalVideoVAE 架构,该架构现在具有更强的性能和更高的推理效率。

生成质量更高、时长更长:我们使用了更高质量的视觉数据和标题以及ShareGPT4Video对长视频进行注释的能力,我们可以生成更高质量和更长的视频。

除了性能改进外,Open-Sora-Plan v1.1.0 还保持了 v1.0.0 的极简设计和数据效率。值得注意的是,我们发现 v1.1.0 表现出与 Sora 基础模型相似的性能,这表明我们版本的演变与 Sora 演示的缩放定律一致。

我们开源了 Open-Sora-Plan,以促进社区视频生成的未来发展。代码、数据、模型将公开提供。

演示:Hugging Face 演示在这里。

代码:所有训练脚本和示例脚本。

模型:此处为 Diffusion Model 和 CasualVideoVAE。

数据:此处为原始视频和字幕。

GitHub:https://github.com/PKU-YuanGroup/Open-Sora-Plan/tree/main

在线体验:https://huggingface.co/spaces/LanguageBind/Open-Sora-Plan-v1.1.0

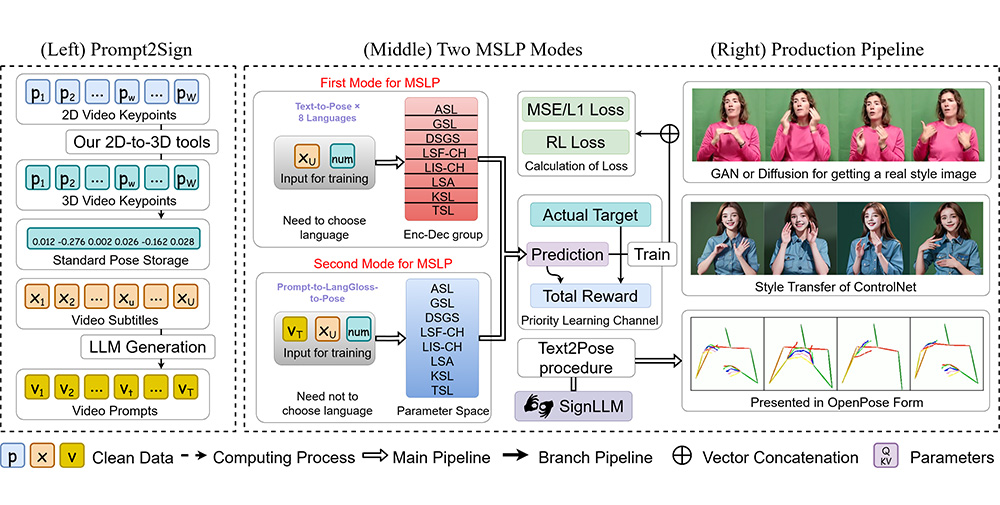

Open-Sora-Plan v1.1.0基于 transformer 的文本到视频扩散系统,基于 T5 的文本嵌入进行训练。

相关文章

Sora Turbo有哪些新功能及价格订阅权益

2024-12-10

腾讯混元文生视频与Sora相比有哪些优势?

2024-12-03

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统