SignLLM:第一个多语种手语生成模型

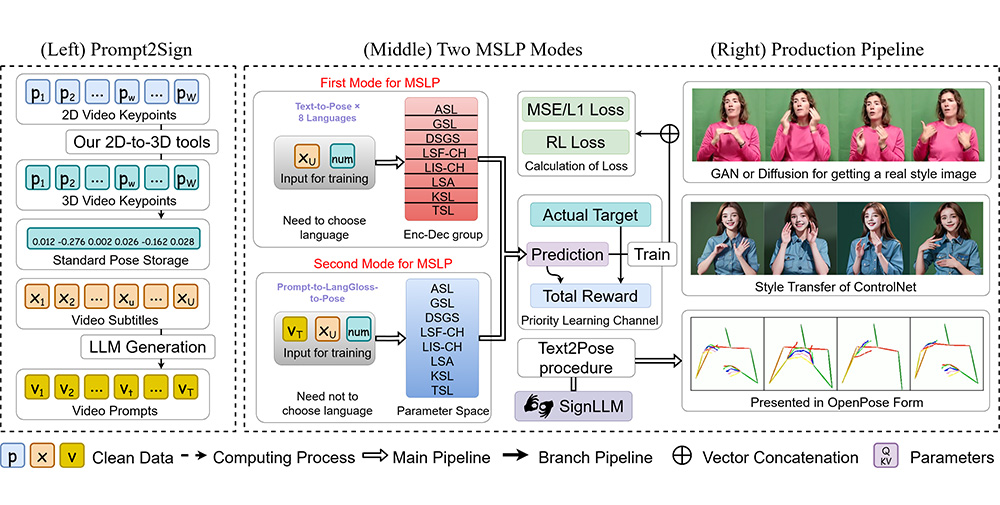

SignLLM,第一个多语种手语生成模型,可以将输入的文本或提示转化为相应的手语手势视频。SignLLM通过先进的ai技术生成和翻译多种手语。SignLLM引入了首个多语言手语数据集,名为 Prompt2Sign,并基于此数据集开发了多种生成手语的模型。此数据集将大量视频转化为便于模型训练的格式,优化了如 seq2seq 和 text2text 等翻译模型的训练。基于这些数据集,我们展示了 SignLLM 的基准结果,表明我们的模型在八种手语的手语生成任务中达到了最先进的性能。

SignLLM受到在广泛的多语言文本语料库上训练的大型语言模型 (LLMs) 强大翻译能力的启发,我们的目标是利用现成的 LLMs 来处理 SLT。在本文中,我们对手语视频进行规范化以体现口语的语言特征,并提出了一种新颖的 SignLLM 框架,将手语视频转换为类似语言的表示形式,以提高现成的 LLMs 的可读性。

SignLLM 包含两个关键模块:

1、矢量量化视觉符号模块将符号视频转换为一系列离散字符级符号标记。

2、代码本重建和对齐模块将这些字符级标记转换为单词级使用最佳传输公式进行符号表示。符号-文本对齐损失进一步弥合了符号和文本标记之间的差距,增强了语义兼容性。我们在两个广泛使用的 SLT 基准测试中取得了最先进的无光泽结果。

SignLLM GITHUB地址:https://signllm.github.io/

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统