阿里云发布Qwen2开源模型

阿里云发布Qwen 2开源模型,性能超越目前所有开源模型和国内闭源模型。

Qwen 2 模型涵盖多种尺寸,包括 0.5B、1.5B、7B、57B-A14B 和 72B 5 种大小版本,Qwen 2模型在同尺寸模型的测评中,都获得了超越所有开源模型的成绩。CompassArena 大模型竞技场上体验了下,确实是很强,应该是目前中文方面非常优秀的了。

Qwen 2功能特征:

5种尺寸的预训练和指令调优模型,包括Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B和Qwen2-72B;

除英语和中文外,还接受过 27 种语言的数据培训;

在大量基准评估中表现最先进;

显着提高编码和数学表现;

Qwen2-7B-Instruct 和 Qwen2-72B-Instruct 的扩展上下文长度支持高达 128K 令牌。

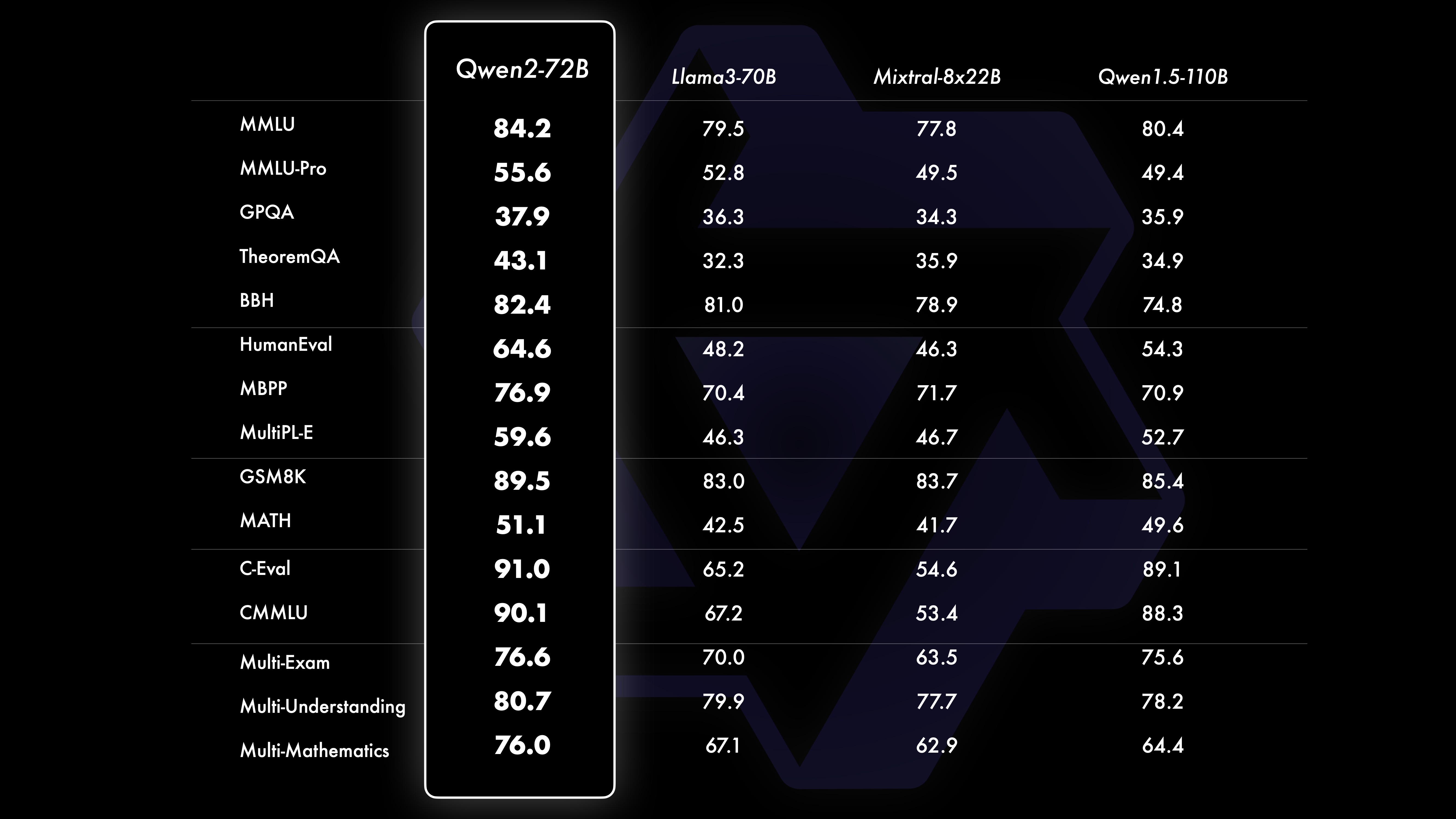

比较评估表明,相对于 Qwen1.5,大型模型(70B+ 参数)的性能得到了显着增强。这里我们评测的重点是大尺寸型号Qwen2-72B。在基础语言模型方面,Qwen2-72B和最先进的开放模型针对不同的能力进行了评估,包括自然语言理解、知识获取、编码能力、数学技能和多语言能力。受益于精心策划的数据集和优化的训练方法,Qwen2-72B 与 Llama-3-70B 等领先模型相比表现出卓越的性能。值得注意的是,尽管参数较少,但它的性能超越了其前身 Qwen1.5-110B。

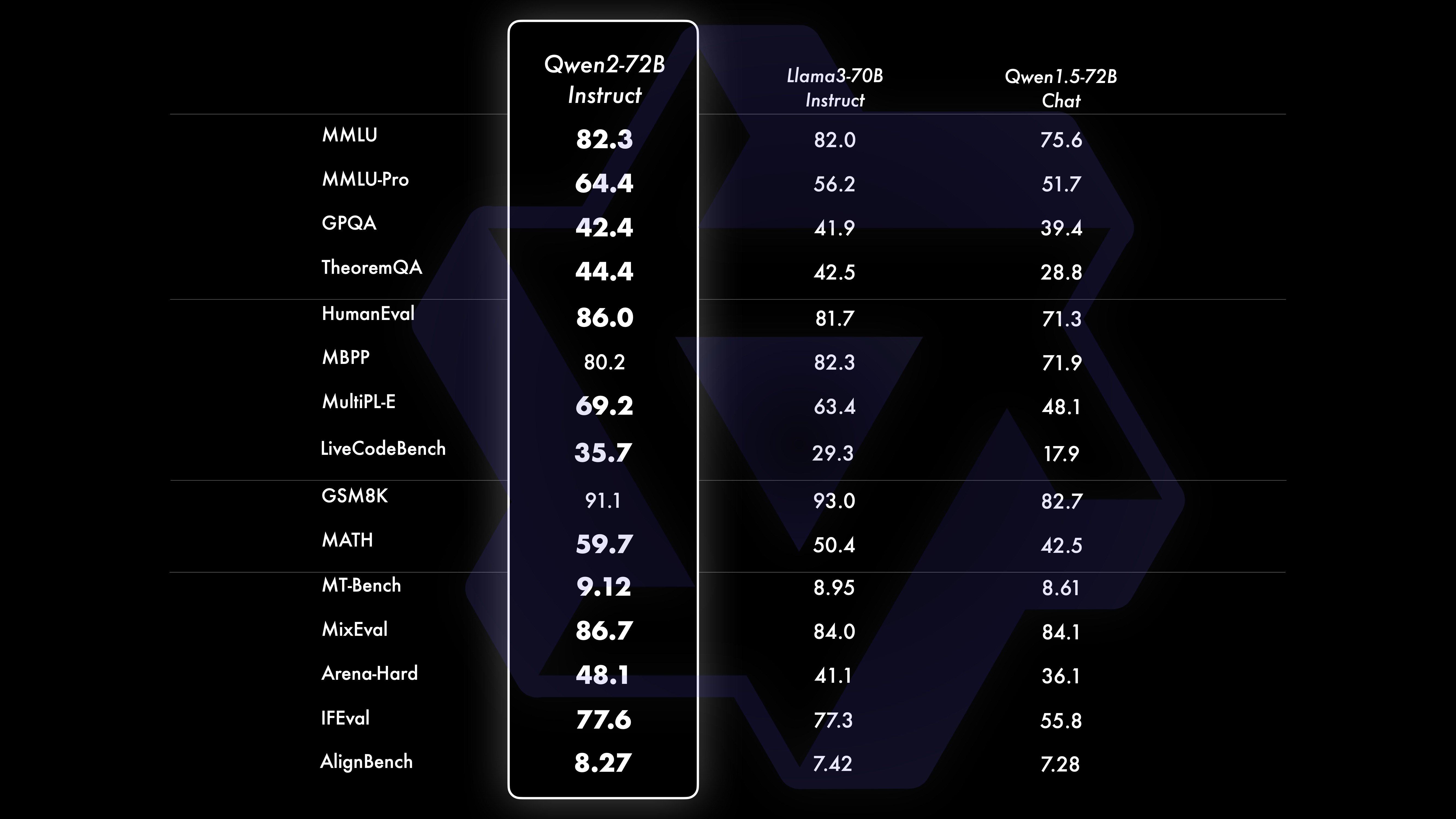

经过广泛的大规模预训练,我们进行后训练,以进一步增强 Qwen 的智能,使其更接近人类。这一过程进一步提高了模型在编码、数学、推理、指令遵循、多语言理解等领域的能力。此外,它将模型的输出与人类价值观保持一致,确保它是有帮助的、诚实的和无害的。我们的训练后阶段的设计遵循可扩展训练的原则,并且需要最少的人工注释。具体来说,我们研究如何通过各种自动对齐策略来获取高质量、可靠、多样化和创造性的演示数据和偏好数据,例如数学的拒绝采样、编码和指令遵循的执行反馈、创意写作的反向翻译、对角色扮演等可扩展的监督。在培训方面,我们采用了监督微调、奖励模型培训和在线DPO培训相结合的方式。我们还采用了一种新颖的在线合并优化器来最大限度地减少对齐税。这些集体努力显着提高了我们模型的能力和智能,如下表所示。

Qwen2 的下一步是什么?

我们正在训练更大的 Qwen2 模型,以进一步探索模型扩展以及我们最近的数据扩展。此外,我们将 Qwen2 语言模型扩展到多模态,能够理解视觉和音频信息。不久的将来,我们将继续开源新模型,加速ai开源。敬请关注!

Github:https://github.com/QwenLM/Qwen2

下载地址:https://modelscope.cn/organization/qwen

体验地址:https://modelscope.cn/studios/opencompass/CompassArena/summary

详细介绍:https://qwenlm.github.io/blog/qwen2/

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统