DeepSeek r1:DeepSeek推出的开源推理大模型,性能对标OpenAI o1

什么是DeepSeek R1?

DeepSeek R1是中国人工智能公司深度求索(DeepSeek)推出的开源推理大模型,通过强化学习驱动的技术路径,在数学、代码和自然语言推理等复杂任务中达到与Openai的o1正式版相当的性能,尤其在推理任务上表现突出。它采用了强化学习技术,显著提升了模型的推理能力,并在极少标注数据的情况下实现了高效的训练。这种方法使得DeepSeek-R1在成本上也具有优势,声称其运行成本仅为OpenAI的3%。

DeepSeek R1核心技术:

一、强化学习驱动的推理能力

纯强化学习(RL)训练:DeepSeek R1-Zero直接在基础模型上应用大规模强化学习,无需监督微调(SFT),首次验证了纯RL可激励LLM的推理能力。模型通过GRPO算法(组相对策略优化)降低训练成本,利用基于规则的奖励系统(准确性奖励和格式奖励)引导模型生成结构化思维链(CoT)。

冷启动数据优化:为解决R1-Zero的可读性和语言混合问题,DeepSeek R1引入了少量冷启动数据(长CoT示例),通过多阶段训练(冷启动微调→推理导向RL→全场景RL)提升输出的可读性和通用性。

长链推理与模型蒸馏

超长思维链支持:支持128K上下文窗口,可分解复杂问题为多步骤推理,例如在数学问题中生成数万字的详细推导过程。

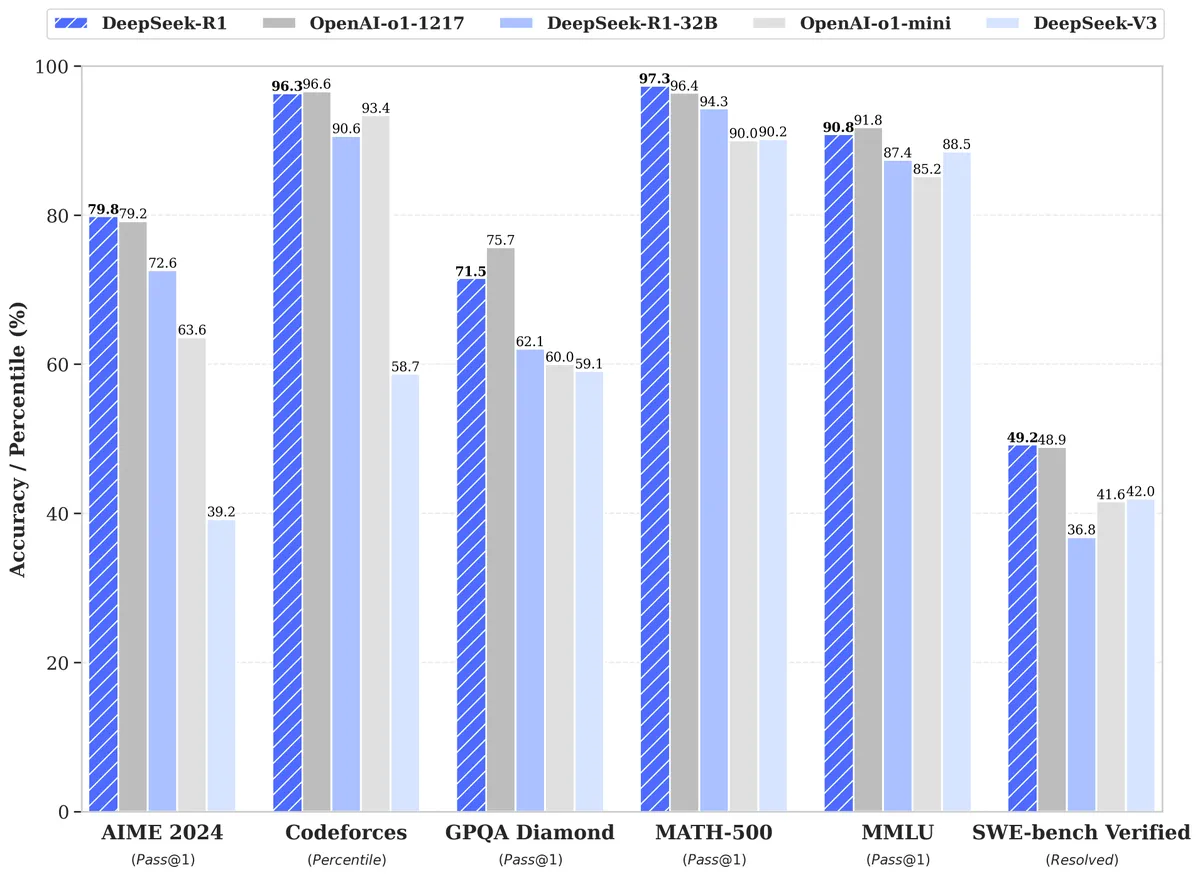

高效蒸馏技术:通过800k样本将R1的推理能力蒸馏至Qwen和Llama系列的小模型(如7B、32B、70B),其中Qwen-32B蒸馏版在AIME 2024测试中达到72.6%的pass@1准确率,性能接近o1-mini。

二、性能表现与基准测试

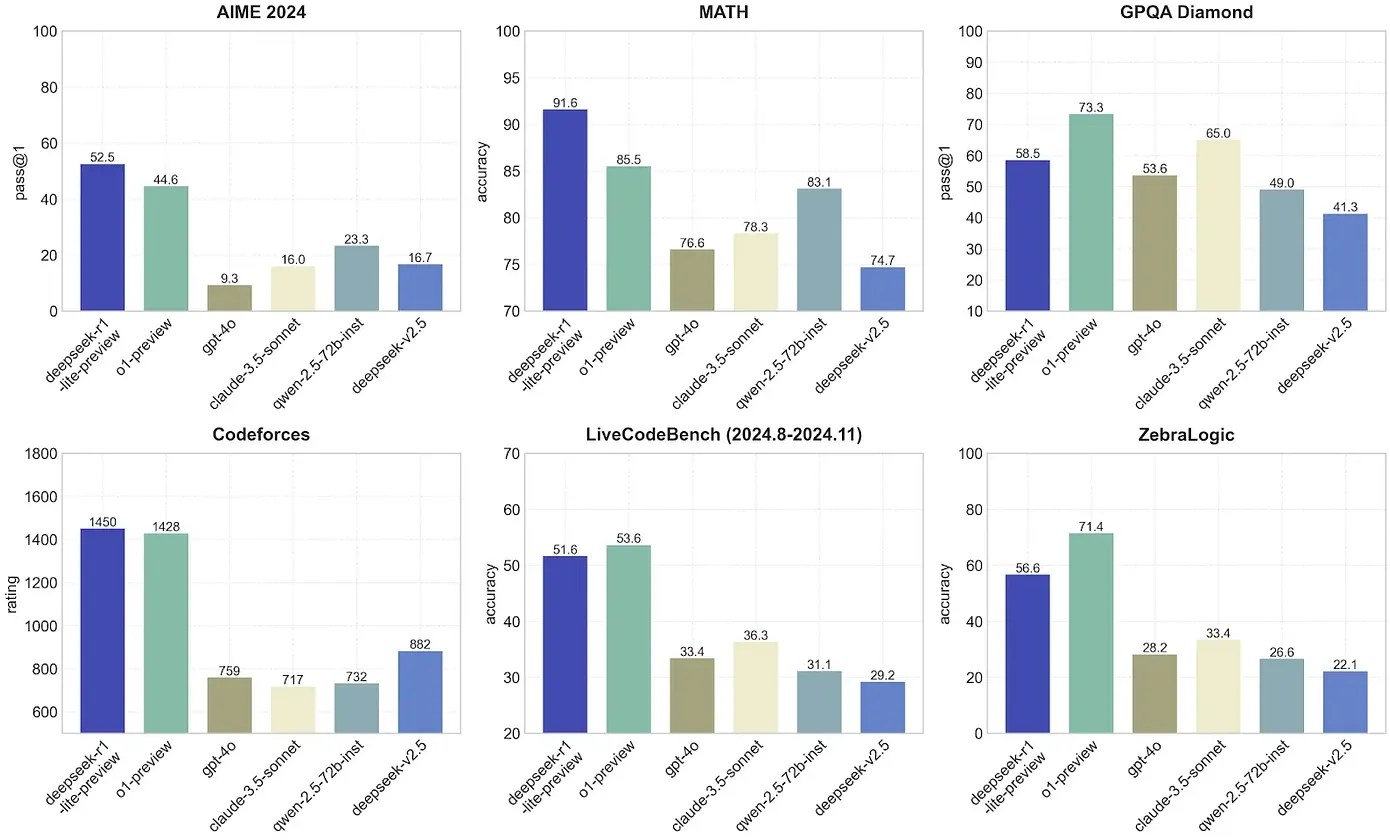

数学与编码能力

数学竞赛级表现:在AIME 2024(美国数学邀请赛)中,R1的pass@1准确率达79.8%,MATH-500基准测试中更以97.3%的成绩超越OpenAI-o1-1217。在高考数学压轴题测试中,R1仅需83秒完成解答,但存在步骤规范性不足的问题。

代码生成专家级水平:Codeforces竞赛中获得2029 Elo评级(超越96.3%人类选手),LiveCodeBench测试pass@1达65.9%。用户实测显示,R1生成量子力学可视化代码仅需9分钟,并可直接运行。

通用语言与知识任务

多领域综合能力:在MMLU(多任务语言理解)测试中得分90.8%,MMLU-Pro达84%,GPQA Diamond达71.5%,显著优于DeepSeek-V3,接近OpenAI-o。

文科与历史推理:处理中文脑筋急转弯正确率达100%,对古埃及历史和非洲原住民等复杂历史问题也能提供逻辑清晰的回答,信息丰富度优于非推理模型。

三、开源生态与低成本优势

开源战略与商业友好性

MIT协议开源:完整模型(671B参数)及6款蒸馏模型(1.5B-70B)均开源,支持免费商用、修改及二次开发。例如,Qwen-14B蒸馏版在桌面级硬件即可运行,LiveCodeBench得分53.1%。

API定价革命:输入Token成本低至1元/百万(缓存命中),输出Token仅16元/百万,约为OpenAI-o1价格的3.7%。用户实测单次API调用成本可低至0.06美元。

开发者工具与集成支持

多平台部署:支持Hugging Face、vLLM框架及Spring AI集成,开发者可通过简单配置调用模型。例如,Spring AI用户仅需添加依赖并配置API密钥即可接入。

推理稳定性优化:API默认关闭temperature参数,确保输出结果稳定性,并通过reasoning_content和content字段分别返回思维链和最终答案。

四、应用场景

科研与教育:辅助数学建模、代码生成及历史分析,提供详实的推理过程,助力学术研究。例如,生成量子力学动画代码或解析复杂数学问题。

企业智能化:集成至客服系统、数据分析工具或自动化决策平台,降低AI部署成本。

R1以开源策略和超低成本(训练成本557.6万美元,约为GPT-4的1/10)推动行业价格战,Meta等公司已成立专项团队研究其技术路径。

Yann LeCun等专家认为,R1的成功标志着开源模型从“追随者”向“引领者”转变,促进全球开发者协作与技术创新。

DeepSeek R1以强化学习驱动的推理能力和开源低成本策略,成为AI领域的重要突破。其不仅在数学、代码等专业任务中表现卓越,更通过开源生态推动全球技术创新,为AGI发展提供了新范式。

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统