OmniHuman:端到端多模态数字人视频生成框架

OmniHuman是字节跳动的一个基于扩散Transformer的多模态数字人视频生成框架。只需用一张照片和一段音频,就可以生成视频,而且动作,口型和表情接近完美。

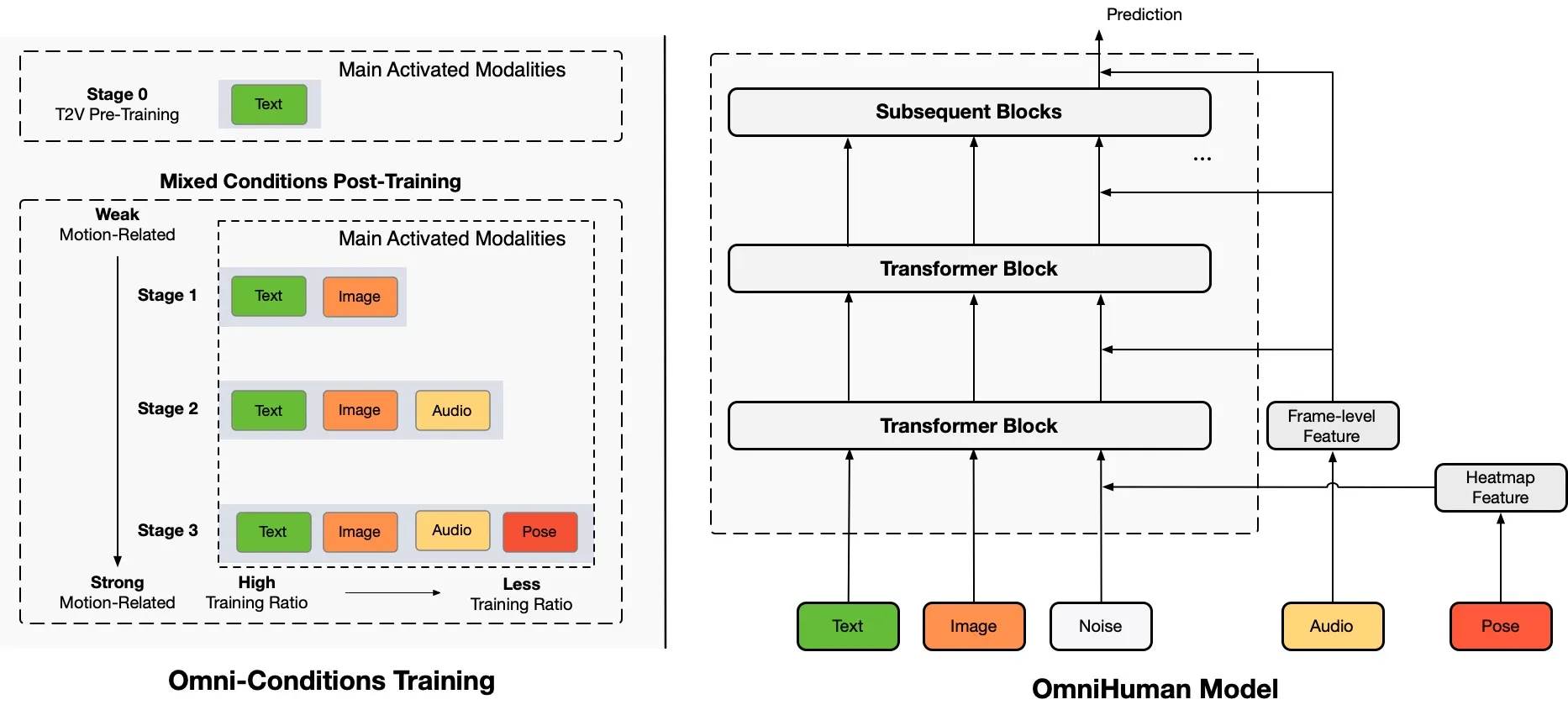

OmniHuman框架通过在训练阶段将与运动相关的条件混合,来扩展数据规模,这一框架的核心在于其能够处理多种输入模态,从而生成更加真实和自然的数字人视频。

OmniHuman关键特性

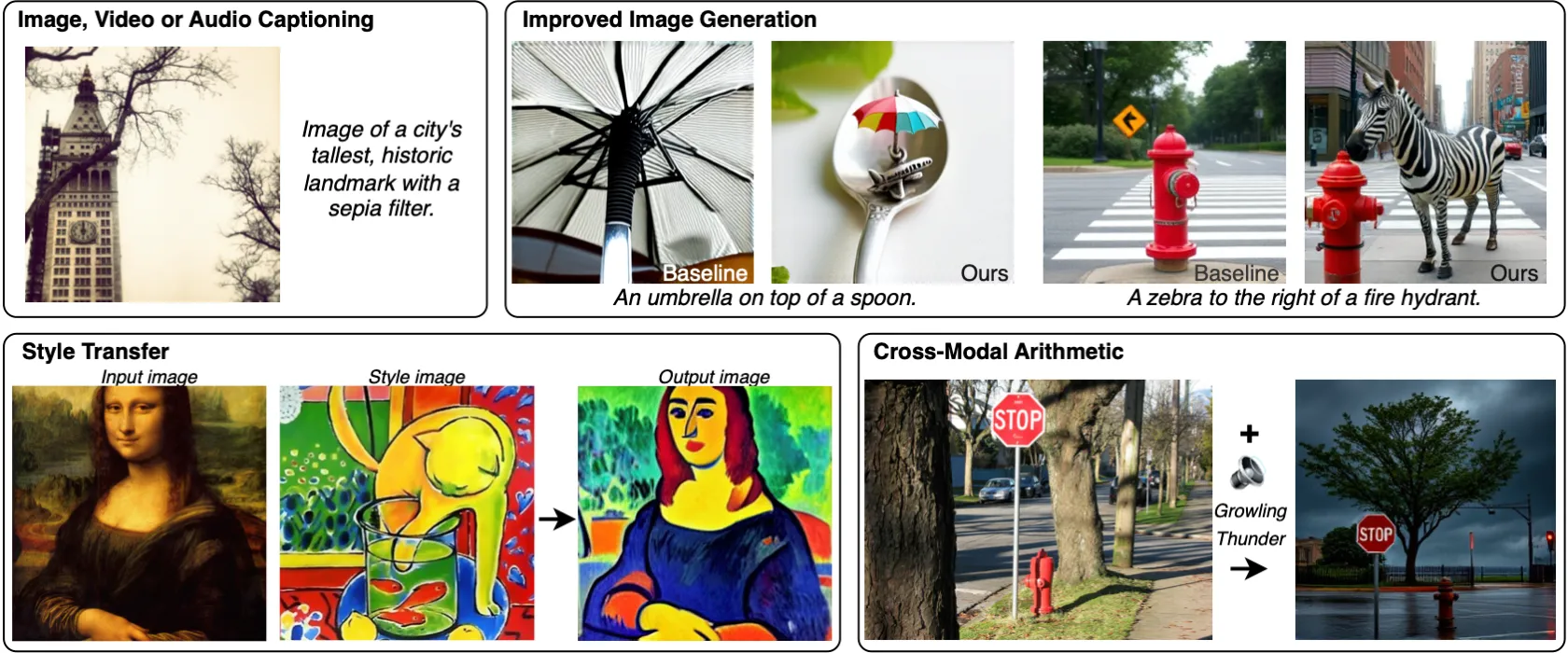

多模态输入:OmniHuman支持多种输入形式,包括文本、音频和视频,使得生成的数字人能够在不同场景中表现出更丰富的情感和动作,融合不同模态数据,突破高质量数据稀缺的瓶颈。

扩展数据规模:通过引入运动相关的条件,OmniHuman能够在训练过程中有效扩展数据集,从而提高生成模型的泛化能力和表现力。

高质量输出:该框架利用先进的深度学习技术,能够生成高质量的数字人视频,不仅支持真人,也支持3D人物和动漫人物,适用于直播、娱乐和教育等多个领域。

实时生成:OmniHuman还具备实时生成的能力,使得用户可以在互动场景中即时获得数字人的反馈和表现。

OmniHuman还支持多种驱动模式,包括音频驱动、视频驱动和组合驱动信号,使用户在输入方面拥有更大的灵活性。此外,OmniHuman能够处理人体与物体的互动和具有挑战性的身体姿势,进一步增强了生成视频的真实感和表现力。OmniHuman框架的设计理念是充分利用数据驱动的动作生成,最终实现高度逼真的人类视频生成。与现有的端到端音频驱动方法相比,OmniHuman不仅能够产生更逼真的视频,还能在输入方面提供更大的灵活性。视频样本可在ttfamily项目页面上找到,展示了其在不同场景下的应用效果。

OmniHuman应用场景

虚拟主播:在直播平台上,OmniHuman可以生成虚拟主播,提供实时互动和娱乐内容。

教育培训:通过生成虚拟教师,OmniHuman可以在在线教育中提供个性化的学习体验。

游戏开发:在游戏中,虚拟角色可以通过OmniHuman生成,提升游戏的沉浸感和互动性。

OmniHuman项目地址:https://omnihuman-lab.github.io

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统