MILS:Meta发布的无需训练就能让LLM获得多模态能力的方法

MILS(Meta Interpretive Learning System),Meta发布的无需训练就能让LLM获得多模态能力的开源ai模型,与传统的训练方法不同,MILS旨在无需额外的特定任务训练就能赋予大型语言模型(LLMs)处理视觉和听觉任务的能力,它能看懂图片视频、听懂声音,零样本学习。

MILS结合了深度学习和解释性学习的优势,能够在多种任务中表现出色,尤其是在需要理解和推理的复杂场景中。

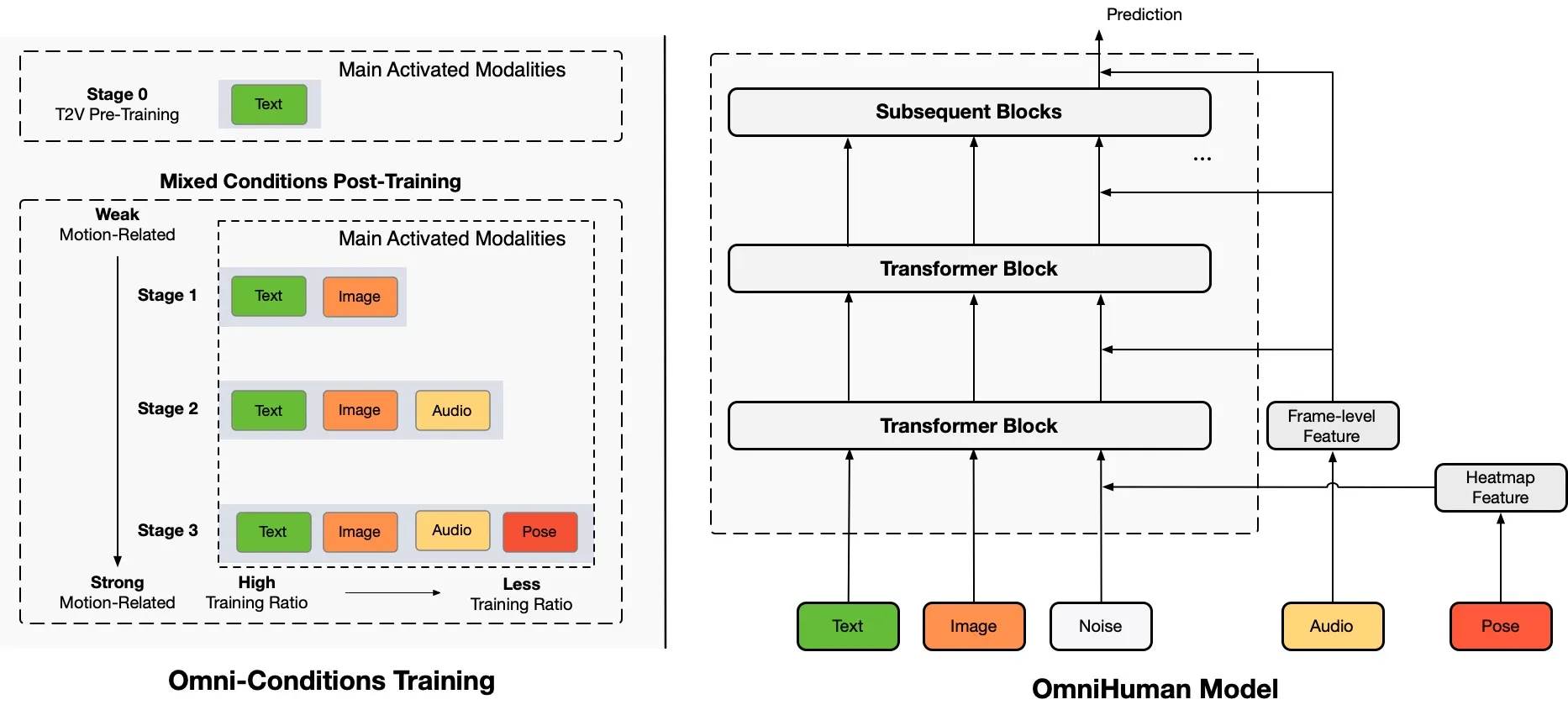

MILS主要有两个模块,一个生成器,负责生成候选方案; 一个评分器,用于评估生成器生成候选方案的质量,通过迭代过程在无额外训练的情况下实现多模态任务的解决。

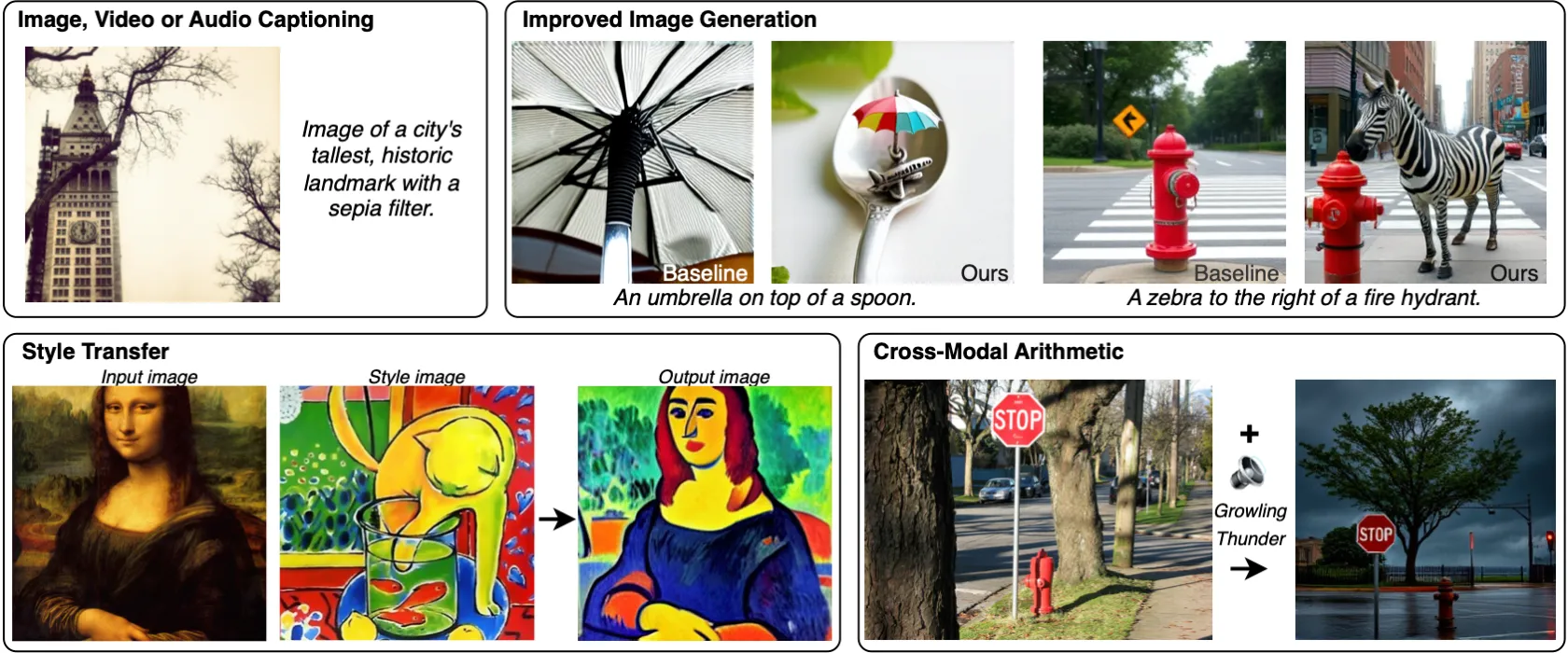

MILS的特点包括支持多种语言和多模态输入,能够处理文本、图像和音频数据,MILS可用于多种多模态任务,像图像/视频/音频描述、图像生成增强、风格迁移等。

MILS关键特点与工作原理

零样本生成:MILS的核心在于其零样本学习能力,意味着模型能够在没有直接针对特定模态任务进行训练的情况下,解决多模态问题。它通过迭代反馈机制,逐步改进生成的输出,从而达到高质量的多模态描述或生成。

迭代反馈循环:在生成过程中,MILS首先让语言模型基于文本提示生成一个初步的多模态输出(如图像描述)。然后,这个输出被用作输入,模型再次尝试生成或优化,通过不断的自我反馈和修正,最终达到满意的解决方案。

利用预训练模型的潜力:MILS依赖于大型语言模型的预训练知识,这些模型已经学习了大量的文本数据,从而能够理解复杂的语义和上下文。通过这种方式,MILS能够利用这些模型的内在能力,跨越到理解和生成图像、声音等非文本数据。

论文:https://arxiv.org/pdf/2501.18096

Github:https://github.com/facebookresearch/MILS

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统