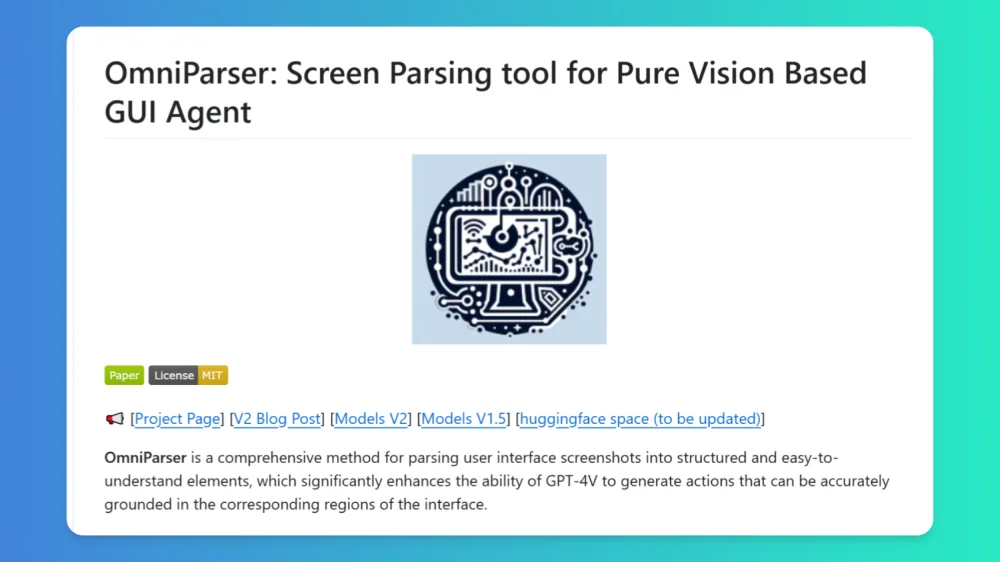

OmniParser V2:微软推出的一款能够将屏幕界面截图转换为结构化数据的幕解析工具

OmniParser V2 是一款能助力计算机理解并交互用户界面视觉信息的强大 ai 工具。它运用视觉和语言模型(VLM),不仅能识别屏幕上的交互元素,还可将复杂的 UI 截图解析为结构化数据,辅助语言模型理解屏幕元素并预测用户交互动作,进而生成精确操作,是极为强大的屏幕理解解决方案。

OmniParser V2的功能特征

多模型兼容:OmniParser V2 能够与多种当下最流行的 LLM 兼容,像 OpenAI、DeepSeek 等,灵活性和应用范围得以大大增强。

视觉语言融合:这款工具巧把视觉和语言模型(VLM)相结合,能精准解析、理解截取的 UI 元素,这对开发智能体意义非凡。

输出结构数据:在解析屏幕截图时,OmniParser V2 可以自动识别与分类 UI 元素,像是按钮、文本框等,再转化为结构化信息,方便后续操作及分析。

生成精准操作:它不但能识别 UI 元素,还能依据识别结果生成相应操作指令,为应用程序的智能自动化开发提供了便捷条件。

OCR 智能提取:运用先进的 OCR 技术,精准识别屏幕文字信息,同时结合图标边界框,保证信息提取得全面且无遗漏。

结构化整合:将图标、文字、边界框和语义标签等整合成有序结构,类似 DOM 树,将界面元素逻辑清晰呈现。

OmniParser V2的应用场景:

自动化办公:能自动处理文档格式,统一 Word 文档排版,自动填充 Excel 数据。

自动化测试:在软件测试方面,借助 OmniParser V2 能够实现对用户界面的自动化测试,提升测试效率和准确性。

GUI 自动化测试:为软件测试提供精确的界面元素识别,还可自动化执行测试脚本来减少人工成本。

用户体验分析:通过解析用户界面数据,企业能深入剖析用户体验,优化产品设计。

智能助手开发:凭借其结构化输出,开发者可打造更智能的助手,使其能够理解并操作各类界面,达成更复杂的用户指令。

教育和培训:用于教育软件中,能够帮助学生通过图形界面与内容进行互动。

OmniParser V2的使用方法

1. 获取资源

从 GitHub 仓库(https://github.com/microsoft/OmniParser)获取项目代码和文档。

在 HuggingFace 模型库(https://huggingface.co/microsoft/OmniParser)下载预训练模型。

2. 环境设置:用户在对应的适宜环境中安装 OmniParser V2,保证兼容的 LLM 可用。

3. 数据输入:准备好后,将需解析的 UI 截图输入 OmniParser V2。若从本地文件夹读取,确保截图格式是 OmniParser V2 支持的常见格式,像 PNG、JPEG 等。

4. 解析过程监控

解析时,若有监控界面,可以通过它查看解析进度,其中会显示当前处理的截图编号、预计剩余时间等信息。

也可查看日志文件(若已生成),这里记录着解析过程的详细信息,包括可能报错的提示等。

5. 数据处理

解析完成后,OmniParser V2 输出的数据通常以 JSON 等格式呈现。

根据应用场景对解析结果处理,比如用于自动化测试,可能需要将解析得到的 UI 元素位置和属性等信息用于编写测试脚本;若是用于数据录入,可能就需要将结果导入到数据库中。

GitHub仓库:https://github.com/microsoft/OmniParser

HuggingFac模型库:https://huggingface.co/microsoft/OmniParser

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 在线生图

在线生图 图生视频

图生视频 文生视频

文生视频 AI数字人系统

AI数字人系统