NSA:DeepSeek团队推出的加速超长上下文的训练和推理技术

DeepSeek团队在2025年2月18日推出了一种创新的注意力机制,名为NSA(Native Sparse Attention)。NSA致力于解决长文本处理过程中遇到的计算效率和性能障碍,这个技术通过硬件一致的设计以及原生训练支持,可以大幅提高推理速度并降低预训练成本。

NSA的主要特性:

硬件友好:设计时考虑了与各类硬件架构的兼容性,旨在提高训练效率。

本地训练能力:支持在数据上直接训练,增强了模型的适应性和灵活性。

高效推理与训练:加速长上下文处理,助力复杂模型的应用,有效应对更长的序列数据,例如文本和视频。

动态层级稀疏策略:利用细粒度标记选择和粗粒度标记压缩技术,在保留信息的同时降低计算复杂性。

成本降低:通过优化设计,显著减少了训练深度学习模型时的资源消耗,包括时间和计算成本,对研究人员和开发者颇具价值。

NSA的核心构成:

动态分层稀疏策略:融合粗粒度Token压缩和细粒度Token选择,提高效率的同时,确保模型对全局上下文和局部细节的感知。

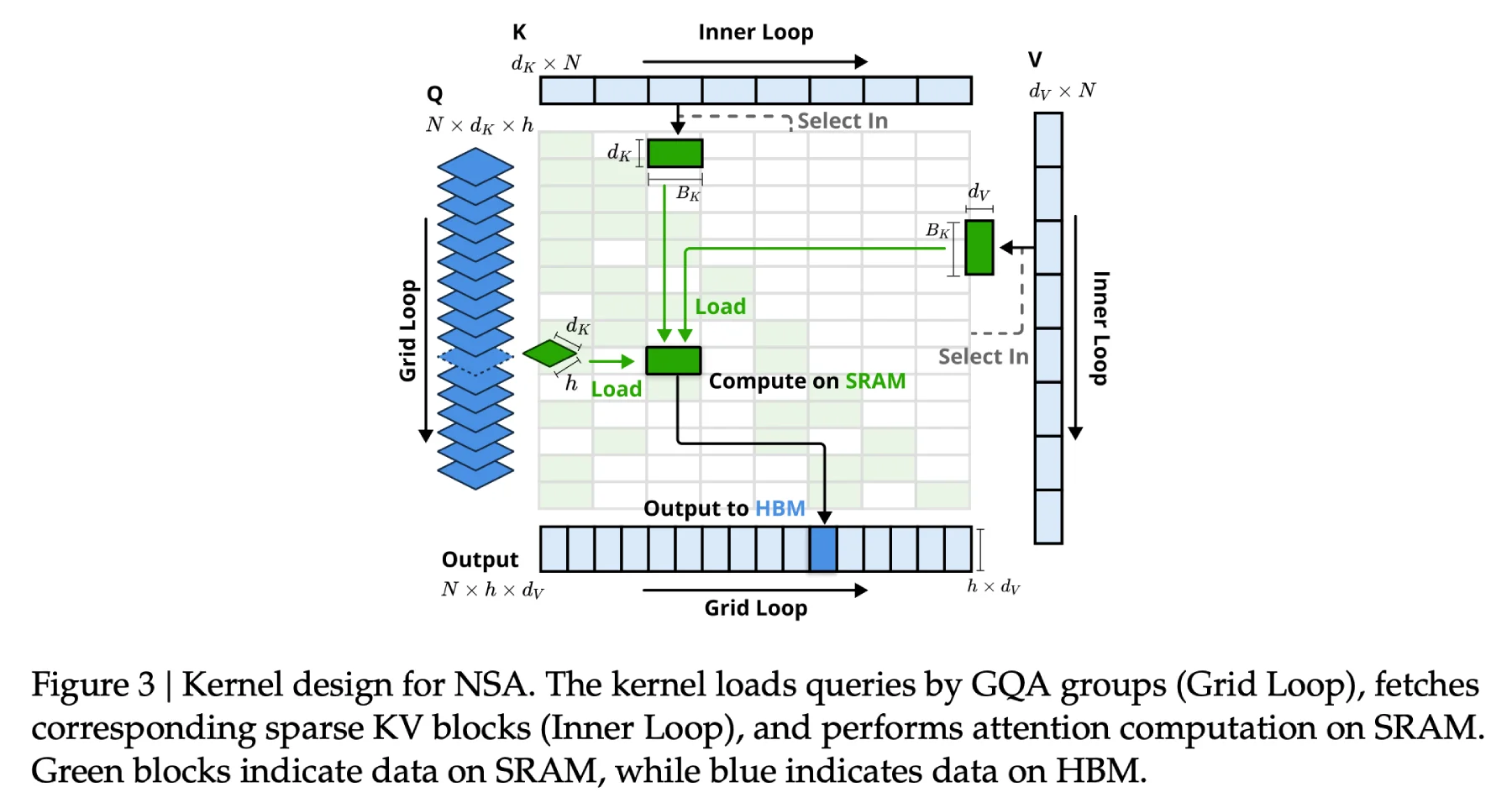

硬件对齐设计:优化内存访问,适配GPU张量核心,分块加载数据,降低冗余传输,增进并行效率。

端到端可训练:支持从预训练到推理的稀疏计算全流程,保持反向传播的稳定性,避免传统稀疏方法的“训练掉队”问题。

NSA的技术细节:

动态分层稀疏策略:灵活地确定关键信息和可忽略信息,优化信息处理,确保模型在处理长上下文时捕捉关键全局语义,同时减轻计算负担。

粗粒度Token压缩:通过整合相似或不重要的Token,减少数据处理量,加速计算,同时保持对文本粗粒度语义的理解。

细粒度Token选择:在压缩数据中进一步筛选重要Token,确保模型关注细节,维持局部精确性,防止重要信息丢失。

滑动窗口:利用滑动窗口机制捕获局部上下文信息,避免忽略近邻关系。

NSA的性能成果:

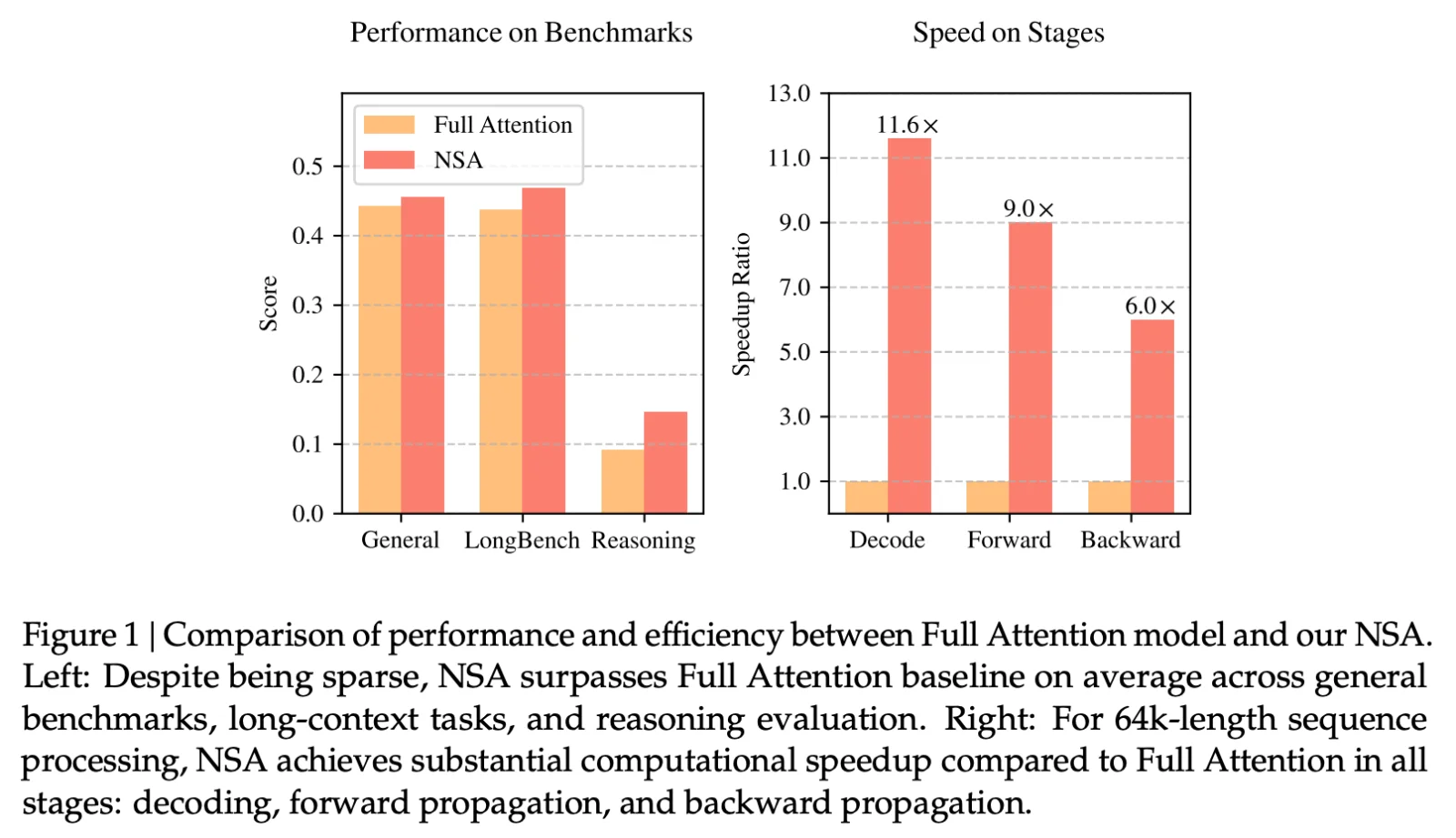

速度提升:处理64k长度序列时,NSA在解码、前向传播和反向传播等阶段实现显著速度提升,最高达11.6倍。

性能优越:在多个基准测试中,NSA表现与全注意力模型相当甚至更优,尤其在长上下文任务和指令推理方面。

NSA的应用领域:

智能助手:实现更复杂的多轮对话和个性化服务。

科学计算:如物理模拟、工程建模中的长序列数据处理。

代码生成与调试:理解长代码库并生成高质量解决方案。

NSA的论文:https://arxiv.org/abs/2502.11089

DeepSeek是一家专注于通用人工智能的中国企业,致力于发掘AGI核心技术并实现产品化。DeepSeek已推出多款高性能开源ai大模型,如支持128k上下文长文本理解的DeepSeek-V2,以及在MT-Bench中文评测中表现优异的DeepSeek-R1-Lite-Preview。

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统