OSUM:西北工业大学开源的一个语音模型,可支持多种语音处理任务

OSUM(Open Speech Understanding Model)是是由西北工业大学计算机科学与技术学院音频、语音与语言处理组(ASLP@NPU)提出并开源的一个语音模型,用于支持多种语音处理任务。

OSUM功能特征:

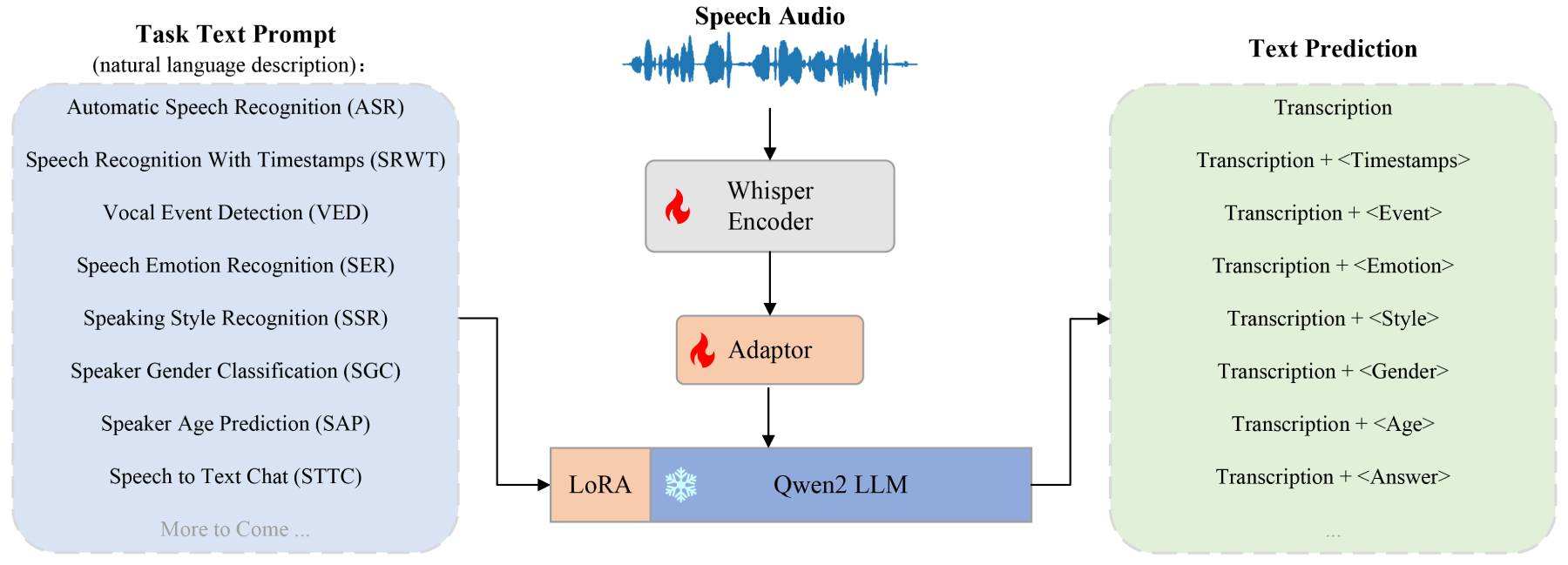

多任务支持:

语音识别(ASR):将语音转换为文本。

带时间戳的语音识别(SRWT):识别语音内容并标注时间信息。

语音事件检测(VED):识别语音中的特定事件或动作。

语音情感识别(SER):分析语音中的情感状态。

说话风格识别(SSR):识别说话人的说话方式或语气。

说话者性别分类(SGC):根据语音判断说话者的性别。

说话者年龄预测(SAP):估计说话者的年龄。

语音转文本聊天(STTC):将语音对话转换为可读文本。

模型架构:OSUM结合了Whisper编码器和Qwen2大语言模型(LLM),使用LORA技术对LLM进行微调,以实现高效的多任务训练。

训练策略:采用ASR+X训练策略,通过同时优化自动语音识别(ASR)和次要任务(X),实现了高效稳定的多任务训练,减少了资源消耗。

深度理解功能:OSUM模型具备将语音信息转化为文本的能力,同时支持语音中的情感识别,能够为用户提供更加智能化的交互体验。

时间戳支持:在语音识别中,OSUM提供带时间戳的输出,便于后续的处理和分析。

多平台兼容:支持在不同的计算平台上运行,包括华为昇腾910B和英伟达平台,这增加了其应用的灵活性。

OSUM应用:

智能助手:在智能家居、虚拟助理中,用于理解和响应用户的语音命令。

情感分析:在客户服务、心理健康应用中分析用户情绪,提供个性化服务。

教育领域:自动评估学生的口语作业,提供反馈。

无障碍技术:帮助听力障碍者理解语音信息。

市场研究:分析消费者反馈中的情感和意见。

语音转录:在会议记录、口述文字转换等场合,利用OSUM进行高效的语音转录。

OSUM使用方法:

安装与导入:用户可以通过Hugging Face页面或GitHub项目页面下载OSUM的代码和模型权重,并按照提供的安装指南进行安装。导入OSUM模型到Python环境的示例代码如下:

from osum import OSUM model = OSUM.from_pretrained("ASLP-lab/OSUM")

执行任务:用户可以使用OSUM模型执行各种语音任务,例如语音识别。以下是一个语音识别任务的示例代码:

result = model.transcribe("audio.wav")

print(f"识别结果:{result}")在使用方法方面,用户还可以利用预训练的模型检查点进行微调,进一步提升模型在特定任务上的性能。

GitHub:https://github.com/ASLP-lab/OSUM

项止:https://aslp-lab.github.io/OSUM.github.io/

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统