阿里巴巴正式开源通义万相Wan2.1视频生成AI模型

Wan2.1是什么?

Wan2.1(通义万相2.1)是阿里巴巴于2025年2月25日正式发布的一个全新的开源视频生成模型,该ai模型基于Apache 2.0协议开源,提供了14B和1.3B两个参数规格的推理代码和权重,支持文生视频和图生视频任务。性能有非常大的提升,在多个基准测试中超越了其他先进模型,包括Sora、HunyuanVideo、Minimax、Luma、Gen3、Pika等国内外视频生成模型。

Wan2.1的功能:

中英文视频生成:

Wan2.1是首个能够生成中英文文本的视频模型,具有强大的文本生成能力,能够生成具有电影级效果的文字和动画。

支持多种场景下的字体应用,包括特效字体、海报字体以及真实场景中的字体展示。

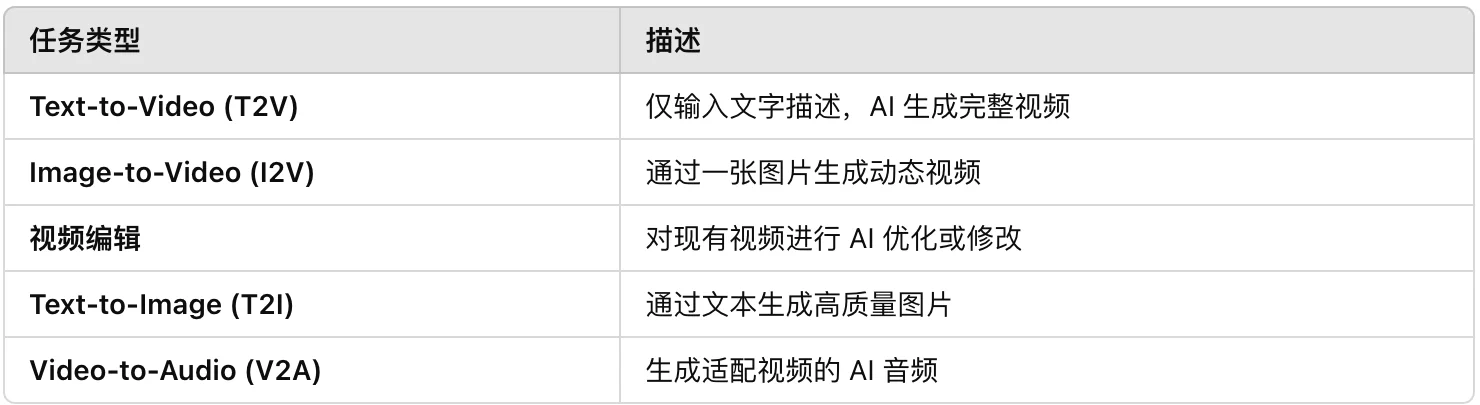

多任务支持:

提供文本到视频(text-to-video)和图像到视频(image-to-video)生成。

支持视频编辑、视频到音频等任务。

文本生成图像(T2I):支持文本到图像生成。

视频生成音频(V2A):可以为视频自动生成匹配的音频。

高质量性能:

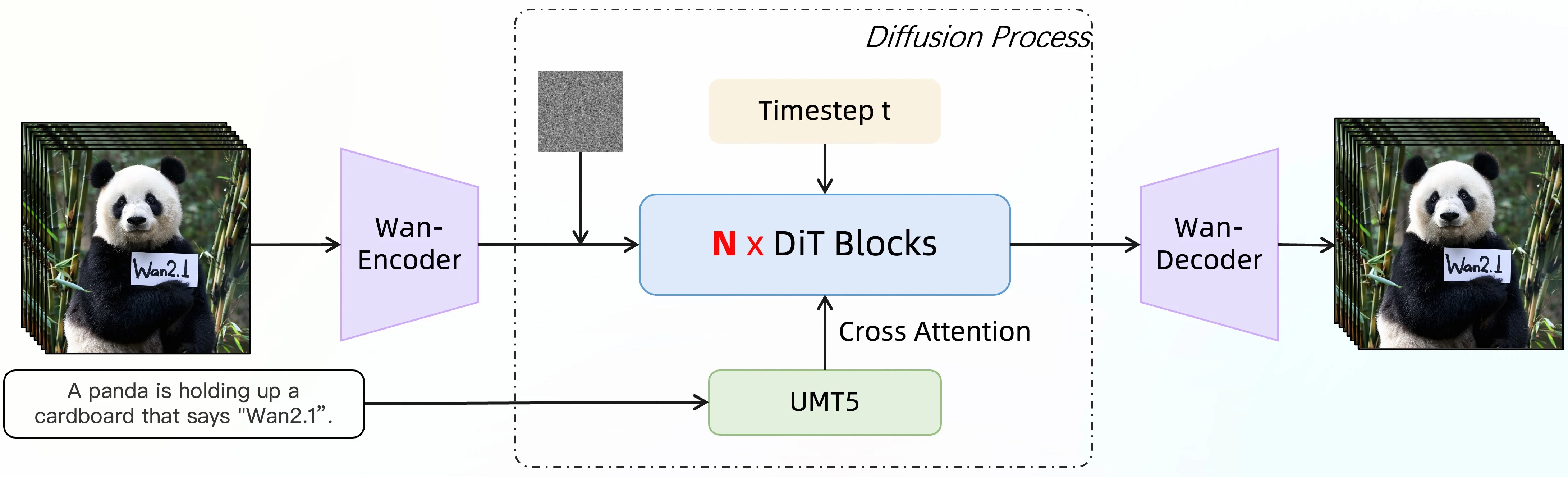

基于混合变分自编码器(VAE)和扩散变换器(DiT)架构,增强了时间建模和场景理解能力。

能够同时生成高清视频、动态字幕和多语言配音,支持1080p分辨率和高效的编解码。

消费级硬件支持:

1.3B版本的Wan2.1模型仅需8.19GB显存即可运行,适用于RTX 4090显卡,使得专业级视频创作进入消费级硬件领域

风格多样化:

支持多种艺术风格,如卡通、电影色、3D风格、油画、古典等。

长视频生成:

通过特征缓存机制,支持无限长1080P视频的生成。

核心架构

混合变分自编码器(VAE):用于视频的编解码,支持无损编解码任意长度的1080P视频流,同时保留时序信息。

扩散变换器(DiT):基于视频的DiT结构,通过Full Attention机制确保长时程时空依赖的有效建模,实现时空一致的视频生成。

Wan2.1的应用:

影视创作:快速打造复杂场景和特效,比如科幻片中的外星世界或宏大的战争场面,大幅降低制作成本和时间。

广告营销:根据品牌特点,定制创意广告视频,提升品牌曝光度和吸引力。

教育培训:制作生动的教学视频和动画课件,帮助学生更直观地理解知识点,丰富教学资源。

游戏娱乐:生成逼真的游戏场景和角色动画,提升游戏画面质感和玩家沉浸感。

短视频与社交媒体:快速产出高质量短视频,适合社交媒体传播,轻松吸引更多观众。

虚拟角色与动画制作:支持复杂角色动作和场景设计,适用于电影、广告或游戏中的虚拟角色创作。

部署方式:

在线体验:

提供了Hugging Face Spaces和ModelScope的在线体验服务。

可通过阿里通义千问APP或网站访问。

本地部署:

提供了详细的本地部署步骤,适用于1.3B模型。

需要确保torch版本大于等于2.4.0,并安装相关依赖。

使用Hugging Face CLI下载模型权重,并通过Gradio框架进行部署。

云端镜像:

推荐使用Runninghub平台在线体验AI应用和工作流。

新注册用户可获得免费额度,支持云端镜像部署。

立即体验:

模型权重:https://huggingface.co/Wan-AI/Wan2.1-I2V-14B-720P

在线体验:https://modelscope.cn/studios/Wan-AI/Wan-2.1(建议使用版本)

ModelScope:https://modelscope.cn/organization/Wan-AI

Github:https://github.com/Wan-Video/Wan2.1

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统