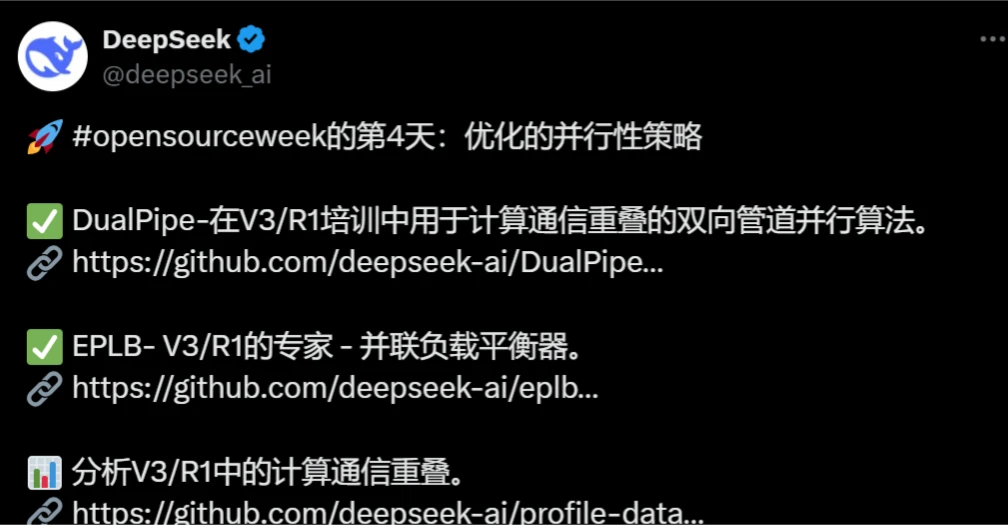

DeepSeek开源周第四天开源项目:DualPipe

DualPipe是什么?

DualPipe是一种创新的双向流水线并行算法,首次在DeepSeek-V3技术报告中提出。它通过实现前向和后向计算与通信阶段的完全重叠,显著提升了大规模模型训练的效率和资源利用率,同时有效减少了流水线中的“气泡”现象。

DualPipe概述

DualPipe是一种创新的双向流水线并行算法,首次在DeepSeek-V3技术报告中提出。它通过实现前向和后向计算与通信阶段的完全重叠,显著提升了大规模模型训练的效率和资源利用率,同时有效减少了流水线中的“气泡”现象。

DualPipe核心创新

计算与通信重叠

DualPipe的核心在于通过双向调度微批次数据,实现了前向和后向计算与通信的完全重叠。这种设计使得计算资源在等待通信完成时不会闲置,从而大幅提高了GPU的利用率。

减少流水线气泡

传统的流水线并行方法(如1F1B和ZB1P)在处理大规模模型时,往往会因为计算与通信阶段的分离,导致效率瓶颈。DualPipe通过优化排列功能模块和精确调控GPU资源分配比例,有效减少了流水线中的气泡现象。

内存使用优化

尽管DualPipe需要维护两份模型参数副本,但由于训练过程采用了大规模梯度累积(EP),这一冗余并未导致显著的内存开销增加。此外,其峰值活性内存仅增加了2倍,相比传统方法更为高效。

DualPipe实现细节

功能模块划分

每个计算块被划分为四个功能模块:注意力机制、全节点数据分发、MLP处理和全节点数据整合。在后向计算块中,注意力和MLP模块还被进一步细分为输入梯度计算和权重梯度计算两个部分。

调度机制

DualPipe采用创新的双向流水线调度策略,实现了从流水线两端同时输入微批次数据。这种设计确保了即使在模型规模进一步扩大的情况下,只要维持适当的计算通信比例,就能在节点间实现细粒度的专家分配,同时将全节点通信开销降至接近于零。

性能对比

与传统的1F1B和ZB1P方法相比,DualPipe在减少流水线阻塞和内存使用方面表现出色。其“气泡”时间显著减少,而峰值活性内存仅略有增加。这种高效的调度方式使得DualPipe在大规模并行场景下具有显著的性能优势。

DualPipe应用前景

DualPipe的出现为大规模模型训练提供了一种高效、可行的并行训练工具。无论是学术研究还是工业应用,这项技术都有望推动ai训练领域的进一步发展。

DualPipe GitHub地址:https://github.com/deepseek-ai/DualPipe

前三天开源项目回顾

FlashMLA:针对NVIDIA Hopper GPU的高效解码内核,优化了多头潜在注意力(MLA)的性能,显著提升了AI工具在内容创作中的响应速度。

DeepeEP:首个用于混合专家模型(MoE)训练和推理的开源通信库,优化了大规模分布式训练的通信效率,降低了延迟。

DeepGEMM:支持稠密和MoE模型的FP8计算库,专为NVIDIA Hopper架构GPU设计,显著提高了计算效率和硬件利用率。

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统