Migician:清华大学等团队出的解决复杂场景下的多图像目标定位问题的多模态模型

Migician 是什么?

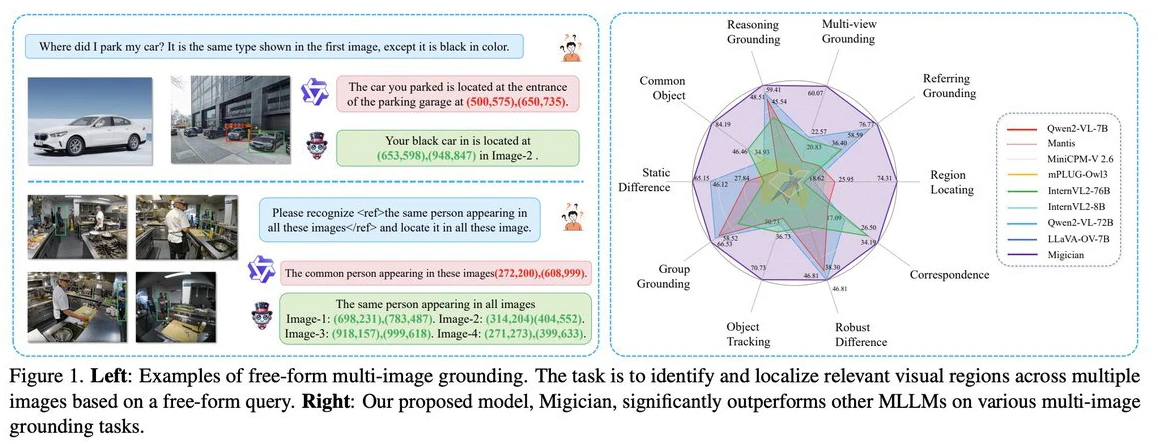

Migician 是由清华大学、北京交通大学和华中科技大学联合开发的一款能够在多图像场景中进行自由形式(free-form)和精确定位的多模态大语言模型。它支持通过文字描述、图片或两者结合的方式,在多张图像中快速定位目标区域,提升了多图像场景中的定位能力。

Migician主要功能

跨图像定位:Migician 支持多种跨图像定位方式,包括“以图搜图”和“文本+图像”组合查询。例如,在安防监控中,输入“身穿黑色上衣、蓝色牛仔裤、头戴白色棒球帽的男子”这样的文本描述,模型就能在众多监控画面中快速定位出符合描述的人员。

多模态融合:通过先进的神经网络架构,Migician 有效整合视觉与语言信息,深入挖掘跨图像的语义关联。例如,在处理“在一组城市街景图像中找到有红色汽车的画面”任务时,模型会提取图像中的颜色、形状等视觉特征,同时解析文本中“红色汽车”的语义信息,然后将两者融合,从而更精准地定位目标。

CoT(Chain-of-Thought)推理优化:Migician 引入 CoT 推理优化,将复杂问题分解为多个简单子问题,逐步推导得出最终答案。例如,在定位某个特定房间内的物品时,模型会先根据文本描述判断该房间可能所在的区域,再在该区域内的图像中精确定位物品。

端到端框架:Migician 采用端到端的框架,直接处理多图像输入,避免了传统分步推理方法中误差累积和效率低下的问题。

模型性能

性能表现:Migician 在多图像定位任务中表现出色,显著优于现有的 MLLM,甚至在多个任务上超越了更大的 70B 模型。具体来说,Migician 在 MIG-Bench 上的表现比现有最好的 MLLM 高出 21.61%。

评估指标:MIG-Bench 提供了 IOU@0.7、IOU@0.5、IOU@0.3 和平均 IOU 等评估指标,用户可以通过运行 MIG_bench_eval.py 脚本进行一键评估。

Migician应用场景

安防监控:实时分析多个监控摄像头的画面,快速定位可疑人员、车辆或异常事件。

自动驾驶:融合车辆多个传感器获取的图像信息,结合对道路、障碍物、交通标志等的文本描述,帮助车辆更准确地感知周围环境。

医疗影像:在多幅医学影像中快速定位病变区域,辅助诊断疾病。

机器人具身智能:帮助机器人在复杂环境中快速定位目标物体,完成抓取、搬运等任务。

Migician项目资源

GitHub仓库:https://github.com/thunlp/Migician

论文地址:https://arxiv.org/pdf/2501.05767

Migician 是一款专门用于多图像定位任务的强大工具,借助大规模数据集 MGrounding-630k 和综合测试基准 MIG-Bench,它在多图像场景中的定位能力得到了显著提升。

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统