CSM:Sesame公司的语音合成模型,如同与真人交流

CSM是什么?

CSM(Conversational Speech Model)是Sesame公司开发的一种对话语音合成模型。它基于Transformer架构,采用端到端的多模态学习方法,能结合上下文和情感背景,合成出极为逼真的真人语音,在语音合成领域表现突出。

CSM的功能特征

自然语音表现:模仿真实人声的语调、节奏和音色,解决传统语音合成系统语调单一的问题,让合成语音宛如真人发声。

细腻情感表达:可融入情感、停顿、重音等自然元素,传递愤怒、悲伤、兴奋等多种情绪,使对话更具感染力。

低延迟响应:通过优化的计算方法,保证对话流畅,ai响应时间极短,接近人类即时反应。

多模态交互:能同时输入文本和语音历史记录,具备上下文感知能力,理解对话背景和情感,让语音更自然、互动性更强。

个性一致性:保持稳定的语音特征,避免在不同情境下出现不协调的情况,消除传统TTS系统的机器人式语调。

对话动态建模:模拟人类对话中的自然停顿、语速、重音等因素,增强语音交互的真实感和互动感。

CSM的技术亮点

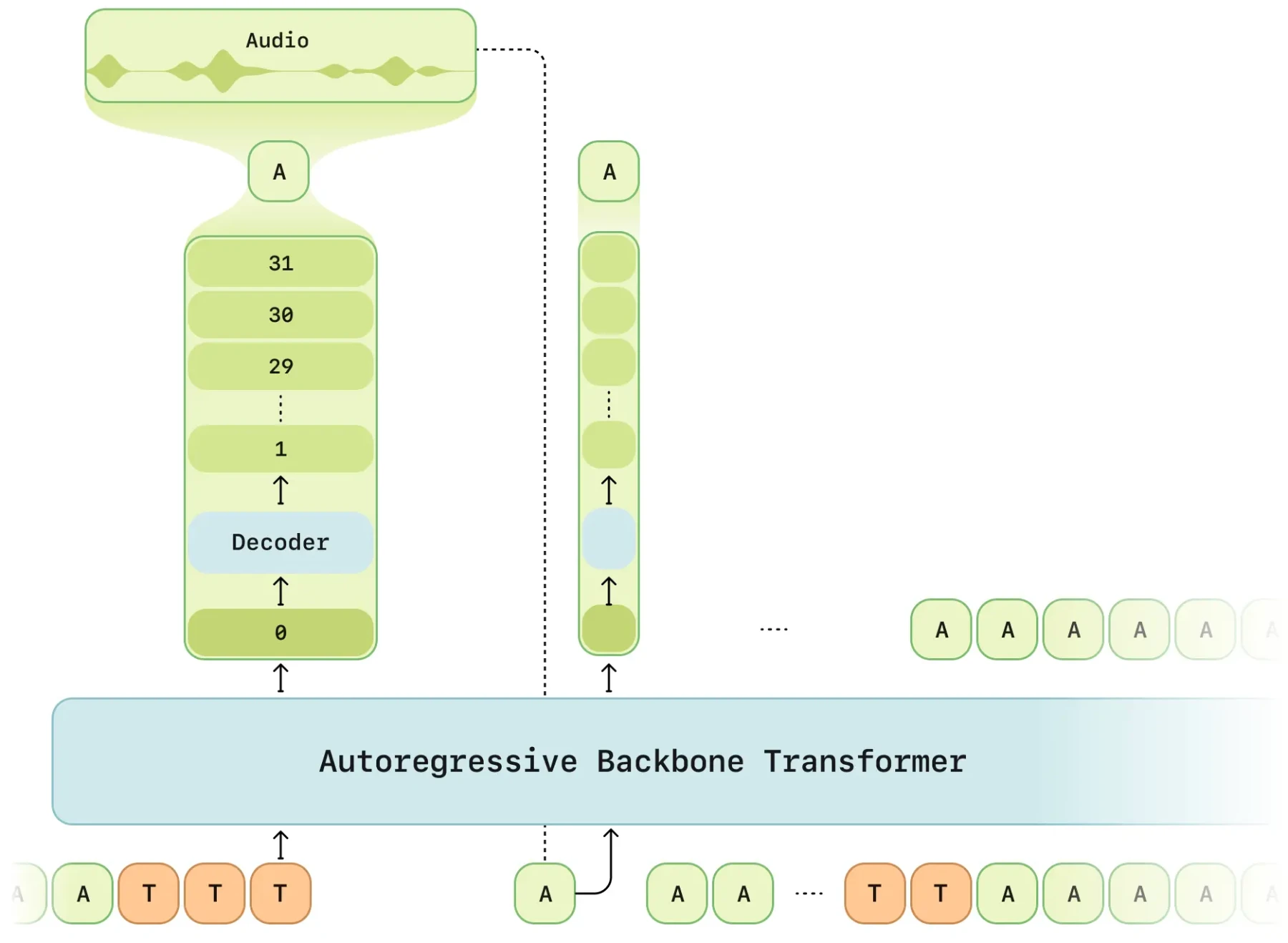

端到端多模态Transformer架构:直接从文本生成高质量语音,无需中间处理步骤。以Transformer为核心,使AI语音具备上下文感知能力。文本用LLaMA Tokenizer处理,语音用Mimi Tokenizer编码,并采用RVQ量化技术。

基于Residual Vector Quantization(RVQ)的音频编码:使用语义Token和声学Token两种音频Token,语义Token代表语音语义和发音特征,声学Token代表音高、音色、韵律等细节。通过层级式RVQ训练,不同层次预测核心和细节特征,避免信息丢失,提升语音自然性。

计算优化与低延迟推理

延迟模式优化:先计算较低级别的RVQ层,再依次计算高层细节特征,加快推理速度。

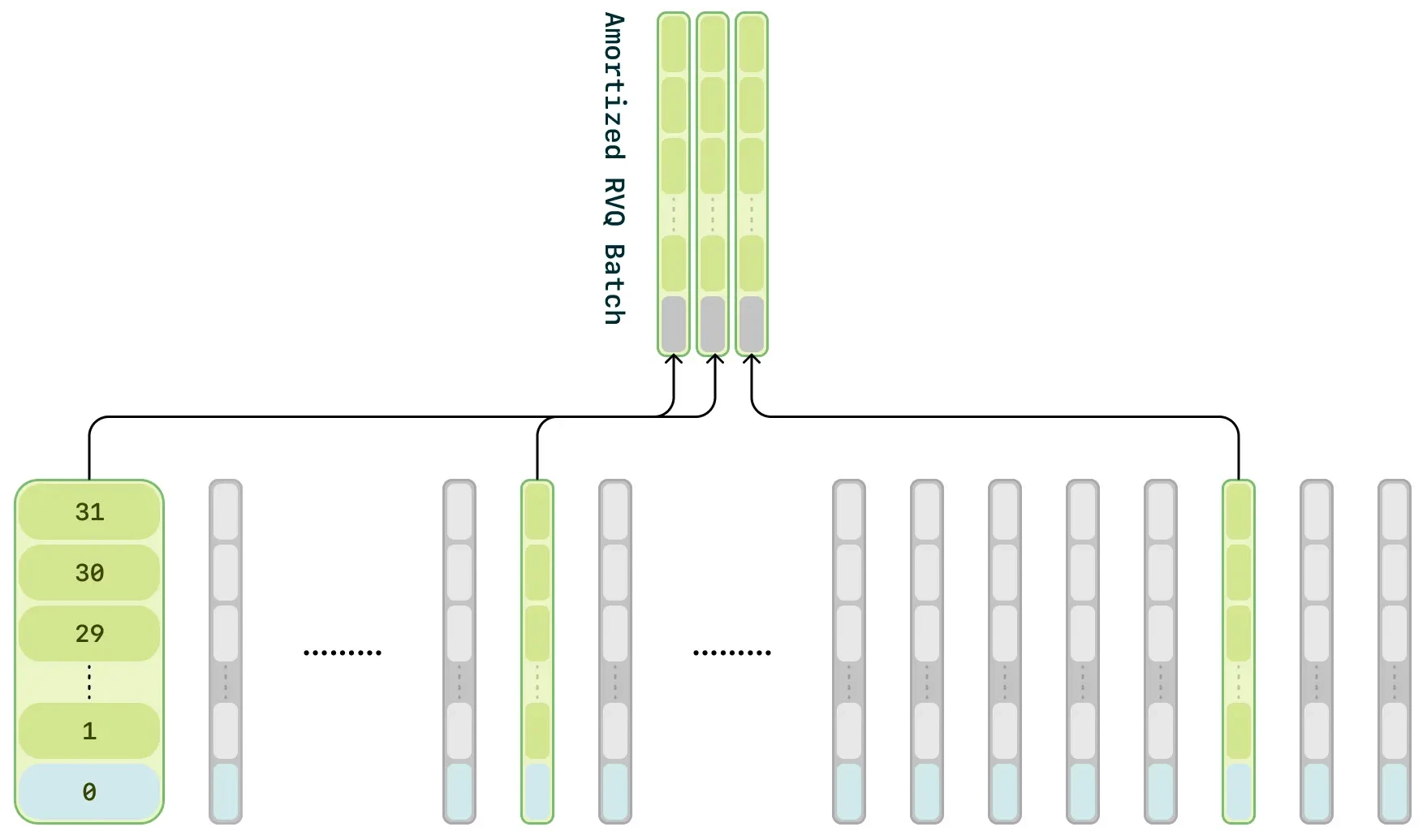

计算分摊:训练阶段随机采样1/16的音频帧优化,减少计算需求且不影响音频质量。

两阶段Transformer结构:主干Transformer处理文本与音频信息,预测基础结构;轻量级解码器细化音频,降低计算量,提高推理速度。

CSM的广泛应用

智能助手:让智能音箱和虚拟助手的语音交互更自然亲切,如同与真人交流。

客户服务:在客服系统中应用,使用户享受更顺畅的交互体验,提升满意度。

教育培训:在语言学习应用中营造真实对话环境,助力学习者理解和练习语言知识。

娱乐产业:为游戏、动画等行业的角色赋予生动逼真的语音,让故事更吸引人。

虚拟助理打造:创造语音更自然的虚拟助理,提供贴心服务。

教育平台互动:在教育平台互动语音对话中发挥作用,提升学习趣味性和效果。

CSM的使用方式

在线体验

可访问Sesame官方网站(sesame.com/voicedemo)体验语音合成技术效果。

集成到产品中

开发者能将Sesame语音模型集成到语音助手、智能客服系统等产品或服务中,提升语音交互能力。

研究与开发

Sesame公司计划扩大模型规模、增加数据集量。研究人员可关注官方介绍及演示(https://www.sesame.com/research/crossing_the_uncanny_valley_of_voice )了解最新成果和技术进展 。

如果想在线体验,可以访问:https://www.sesame.com/research/crossing_the_uncanny_valley_of_voice#demo

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统