DiffRhythm:全球首个基于扩散模型的端到端音乐生成工具

DiffRhythm是什么?

DiffRhythm是全球首个基于扩散模型的端到端AI音乐生成工具。不管你是刚接触音乐的新手,还是经验丰富的专业制作人,只要输入歌词、风格、情感等文字描述,它就能快速产出各种风格的音乐,从古典交响乐到赛博朋克风都不在话下,不需要人工干预就可以帮你轻松创作属于自己的音乐作品。

DiffRhythm功能特点

端到端生成:直接处理原始音频波形,省去中间符号转换环节,让音乐里细腻的情感得以完整保留。

多模态理解:能综合文本、音乐甚至图像信息,精准把握像“温暖复古”“未来科技感”这类比较抽象的风格特点。

动态可控性:可以实时对节奏、和弦走向进行调整,就像用调色盘调配颜色一样灵活地组合音乐元素。

潜在扩散模型:基于扩散模型,在短短十秒内就能合成包含人声和伴奏的完整歌曲,时长最长可达4分45秒,而且音乐性和可懂度都很高。

非自回归结构:推理速度快,结构简单,保证了工具的可扩展性。

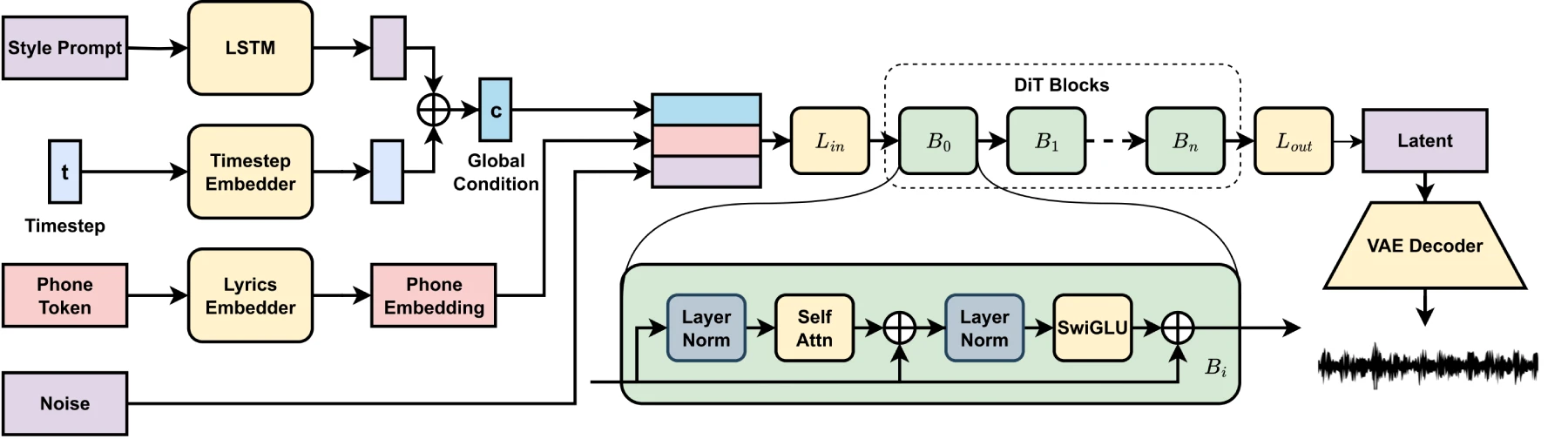

DiffRhythm核心技术

DiffRhythm的核心是扩散模型,工作原理有点像玩“噪声消除游戏”,分两个阶段:

前向加噪:把原始音乐片段一点点加上随机噪声,直到变成白噪音。

反向去噪:通过训练好的神经网络,从这些噪声里慢慢还原出符合用户要求的音乐,最终得到高质量音频。

相比传统ai音乐工具的优势

端到端生成:直接处理原始音频波形,无需中间转换,保留细腻情感。

多模态理解:结合多种输入,精准捕捉抽象风格。

动态可控性:实时调整节奏、和弦走向,灵活组合音乐元素。

DiffRhythm如何使用

AI生成带时间戳的歌词:你可以设定歌曲主题和风格,让AI生成带时间戳的歌词;也能自己写好歌词后添加时间戳。

生成歌曲:把带时间戳的歌词输入界面提交,就能得到歌曲。不过目前版本生成的歌曲最长为95秒,歌词太长会被截断。

DiffRhythm应用

内容创作者:短视频博主能在一分钟内生成适配视频情绪的背景音乐,不用担心版权问题。

独立游戏开发者:低成本打造高品质场景音效库。

音乐产业:唱片公司借助AI辅助创作热门歌曲的Remix版本,延长IP的生命周期。

演出行业:实时生成与观众互动反馈同步的即兴音乐 。

GitHub仓库:https://github.com/ASLP-lab/DiffRhythm

在线演示:https://huggingface.co/spaces/ASLP-lab/DiffRhythm

项目地址:https://aslp-lab.github.io/DiffRhythm.github.io/

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统