HunyuanVideo-I2V:腾讯混元开源的图像转视频生成框架

HunyuanVideo-I2V 是什么?

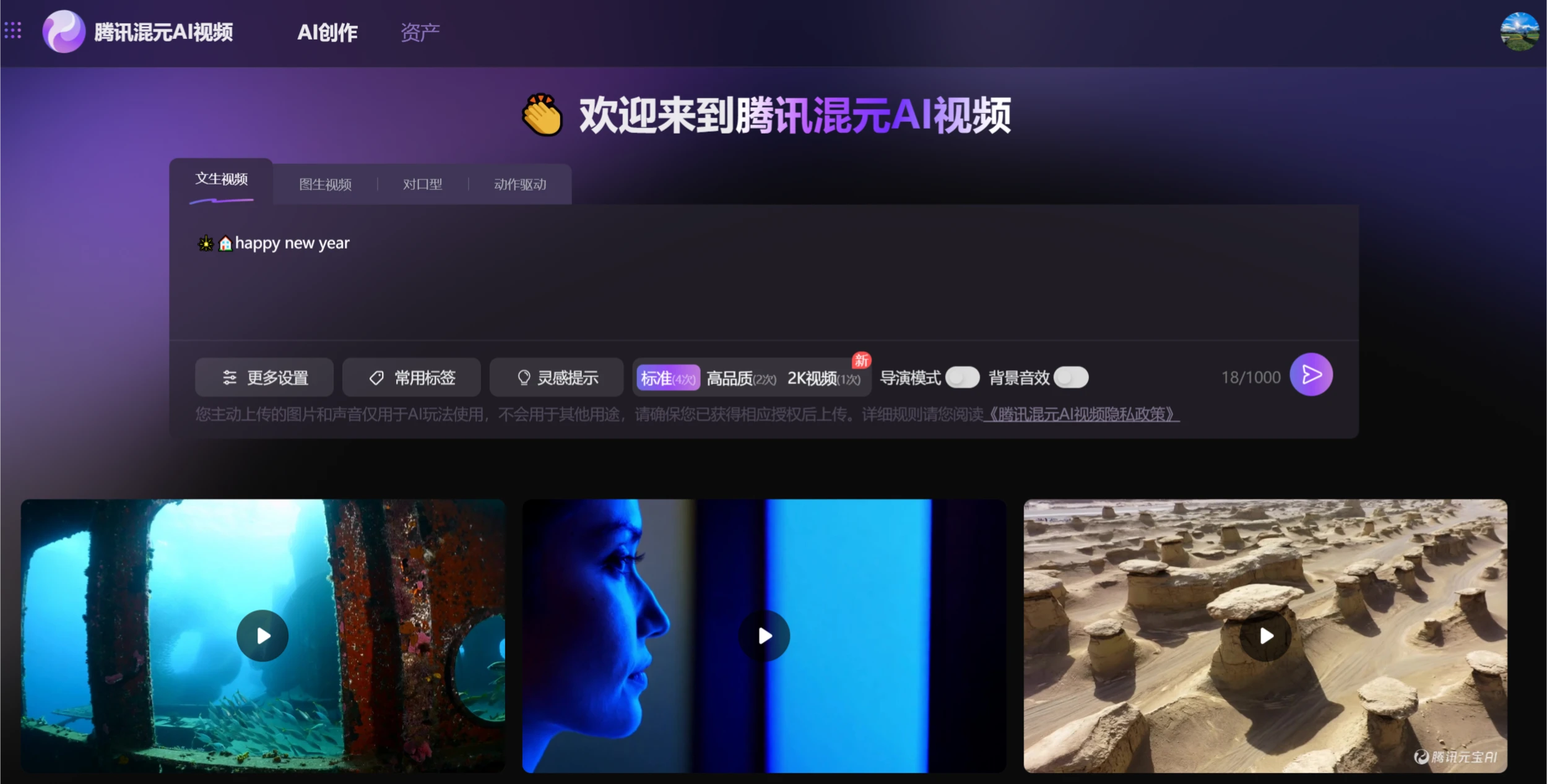

HunyuanVideo-I2V是腾讯混元团队于2025年3月6日开源的全新图生视频框架。该框架基于之前开源的HunyuanVideo,进一步扩展了图像到视频生成的能力,视频创作者可以从单张图片生成高质量的短视频,并支持定制化特效训练。

HunyuanVideo-I2V功能特点

图生视频:HunyuanVideo-I2V 可以将静态图像作为视频的第一帧,根据用户输入的字幕或描述生成匹配的视频内容。

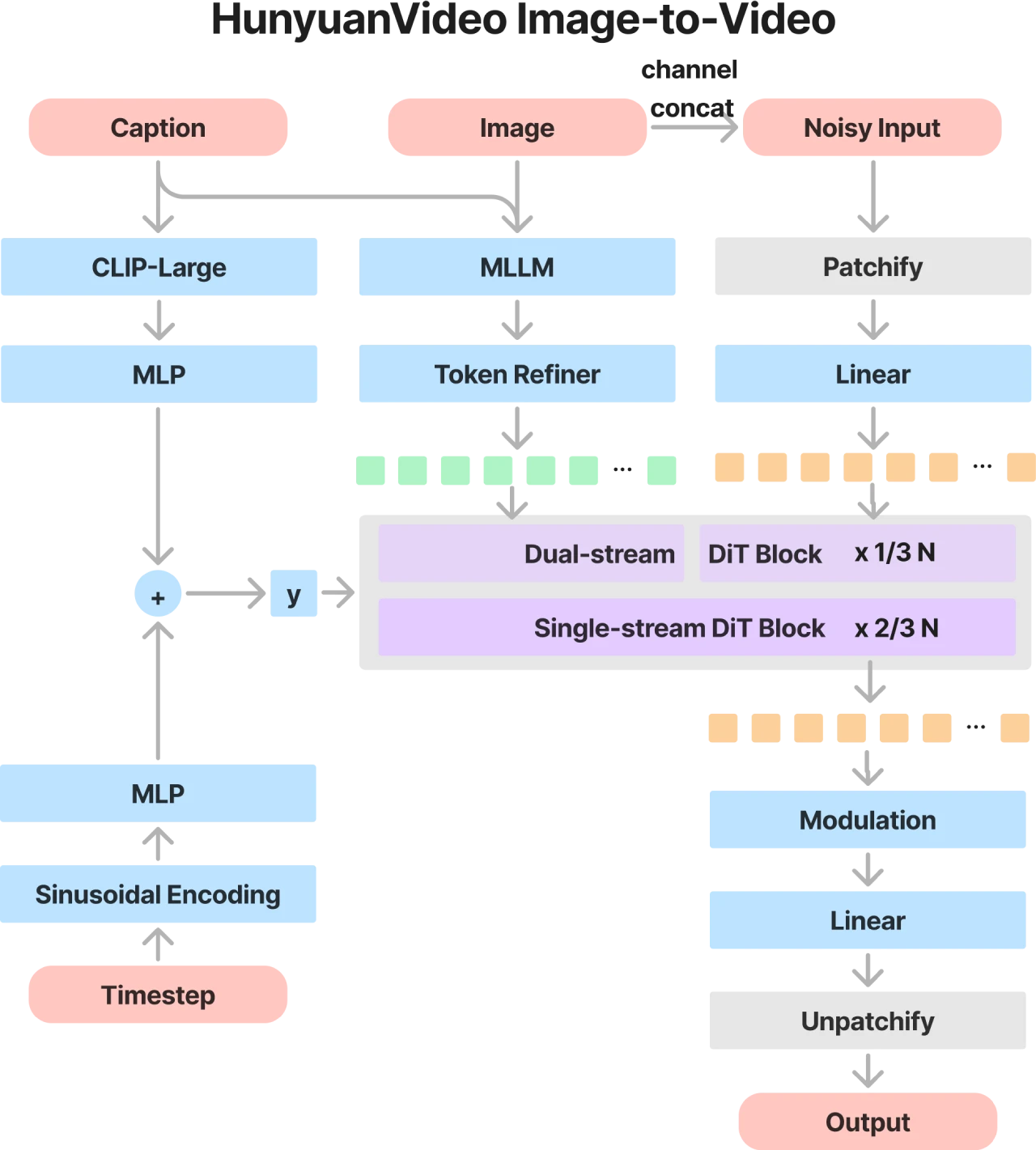

多模态大语言模型(MLLM):该模型采用预训练的多模态大语言模型作为文本编码器,显著增强了对输入图像语义内容的理解能力。

3D变分自编码器(3D VAE):使用CausalConv3D技术训练的3D VAE,将像素空间中的视频和图像压缩到紧凑的潜在空间,减少后续模型中的token数量。

双流转单流的混合模型设计:在双流阶段,视频和文本token通过多个Transformer块独立处理;在单流阶段,将视频和文本token连接起来,进行多模态信息融合。

渐进式训练策略:从低分辨率、短视频逐步过渡到高分辨率、长视频,提高模型的收敛速度。

提示词重写模型:解决用户提示词的语言风格和长度多变性问题,将用户输入的提示词转换为模型更易理解的格式。

可定制化LoRA训练:支持通过少量数据训练出具有特定效果的视频生成模型,例如“头发生长”或“人物动作”等特效。

高效推理:提供单GPU推理和多GPU序列并行推理,支持更快的推理速度。

HunyuanVideo-I2V技术架构

HunyuanVideo-I2V在整体架构上延续了HunyuanVideo的设计思路,并在此基础上针对图像到视频生成任务进行了优化。其核心在于利用图像隐空间拼接技术,将参考图片的关键信息注入到视频生成流程中,同时通过MLLM实现文本和图像信息的跨模态深度融合。

HunyuanVideo-I2V使用方法

1. 安装与依赖

安装PyTorch和其他依赖项,具体安装指南可在GitHub页面找到。

推荐使用NVIDIA GPU,至少需要80GB的显存。

2. 下载预训练模型

预训练模型权重可在GitHub页面或Hugging Face页面下载。

3. 推理代码

使用提供的推理代码(如sample_video.py)生成视频。

4. LoRA训练

提供LoRA训练代码,用户可以通过少量数据训练出具有特定效果的视频生成模型。

HunyuanVideo-I2V应用场景

视频内容创作:为视频创作者提供高效、高质量的视频生成工具。

影视制作:生成影视级视频内容。

个性化视频:根据用户上传的图片和描述生成个性化视频。

官网:https://video.hunyuan.tencent.com/

GitHub:https://github.com/Tencent/HunyuanVideo-I2V

Hugging Face:https://huggingface.co/tencent/HunyuanVideo-I2V

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统