Vid2Avatar-Pro:从单目自然视频中生成逼真的3D人体虚拟形象

Vid2Avatar-Pro是什么?

Vid2Avatar-Pro 是一种能够从普通的单目自然视频中创建逼真且可动画化的3D人体虚拟形象的技术。它是 Vid2Avatar 的升级版本,通过引入通用先验模型(Universal Prior Model, UPM)和优化的 3D 表示方法,提升了虚拟形象的逼真度和泛化能力。

Vid2Avatar-Pro功能特征

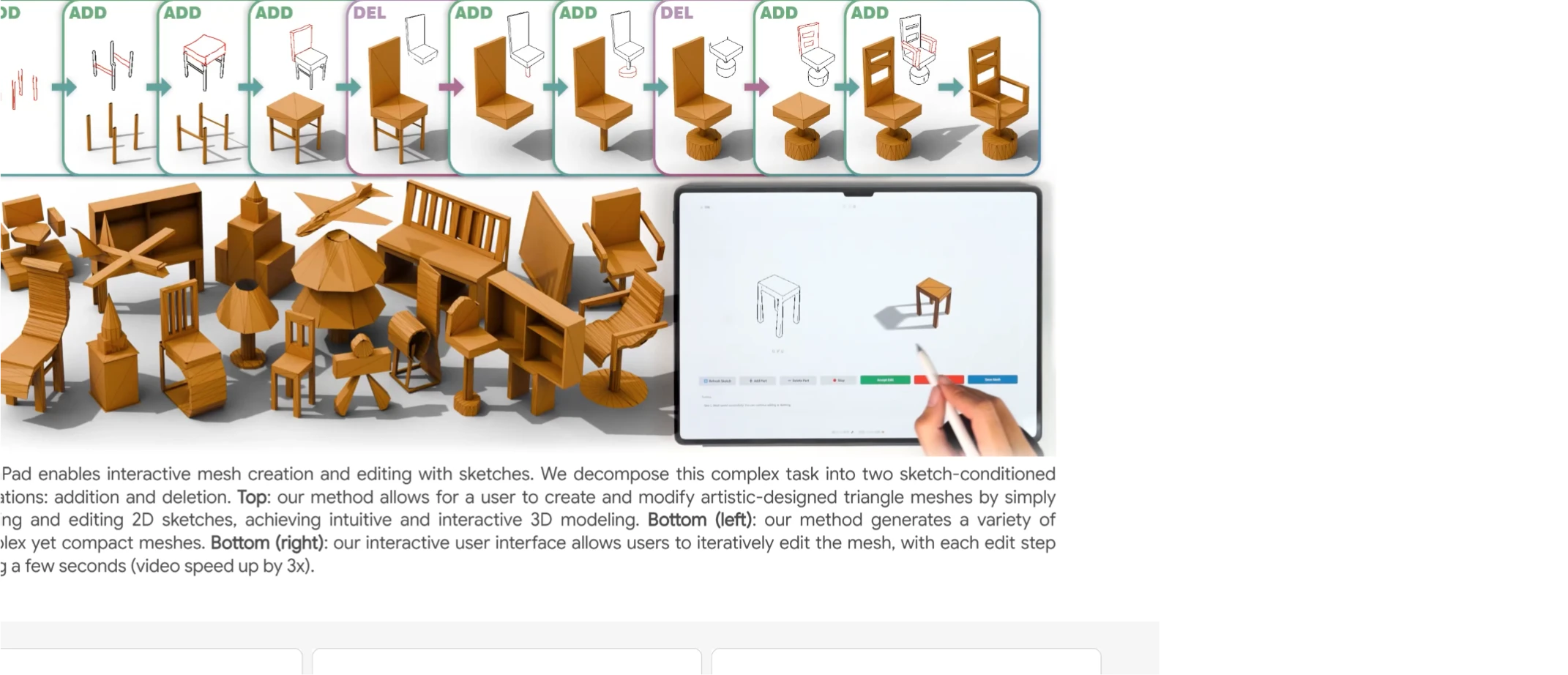

高逼真度与可动画性:Vid2Avatar-Pro 能够从普通单目视频中生成逼真的 3D 虚拟形象,并支持复杂的动作动画。

多视角渲染:生成的虚拟形象可以被渲染到任意视角,解决了传统方法中视角受限的问题。

多样化动作支持:虚拟形象能够执行多种复杂动作,如打羽毛球、打鼓、单腿跳跃等。

通用先验模型(UPM):通过大规模多视角数据预训练的通用先验模型,显著提升了对新姿态和视角的泛化能力。

Vid2Avatar-Pro应用场景

影视制作:从普通视频中重建演员的 3D 模型,用于特效制作。

虚拟现实(VR)与增强现实(AR):创建逼真的虚拟角色,提升沉浸感。

时尚与电商:通过视频重建用户 3D 模型,实现虚拟试衣。

体育分析:从比赛视频中重建运动员模型,分析动作细节。

医疗康复:记录和分析患者康复过程中的动作。

Vid2Avatar-Pro 技术原理

通用先验模型(UPM)

预训练阶段:使用大规模多视角、动态的穿衣人类表演数据训练 UPM,使其能够捕捉人类外观和姿态的通用特征。

微调阶段:在给定的单目野外视频上,通过逆渲染技术对预训练的 UPM 进行微调,恢复特定人物的细节。

3D 高斯表示

使用规范前后地图的 3D 高斯表示来构建虚拟形象,这些地图在不同身份之间共享。

通过正向线性混合蒙皮(LBS)和光栅化技术合成训练姿态/形状参数。

自监督场景分解

不依赖外部分割模块,直接在 3D 中分离人体和背景。

通过两个独立的神经场对人物和背景进行参数化,解决了场景分解和表面重建任务。

优化策略

引入由粗到细的采样策略和新颖的目标函数,清晰地分离动态人体和静态背景。

优化背景模型、规范化的人体形状和纹理以及每帧人体姿态参数。

Vid2Avatar-Pro使用方法

1. 数据准备:

使用 ROMP 获取初始 SMPL 形状和姿势。

使用 OpenPose 提取关键点。

2. 模型训练:

对背景模型、人体形状纹理和姿态参数进行联合优化。

使用预训练的 UPM 模型进行微调。

3. 生成与渲染:

使用训练好的模型生成最终的 3D 虚拟形象。

通过逆渲染技术实现多视角渲染。

4. 动画生成:

将虚拟形象绑定到新的动作序列,实现多样化动画。

论文链接:https://moygcc.github.io/vid2avatar-pro/static/CVPR2025_Vid2Avatar_Pro.pdf

项目主页:https://moygcc.github.io/vid2avatar-pro/

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 在线生图

在线生图 图生视频

图生视频 文生视频

文生视频 AI数字人系统

AI数字人系统