Open-Sora 2.0:潞晨科技推出的一款开源SOTA视频生成模型

Open-Sora 2.0是什么?

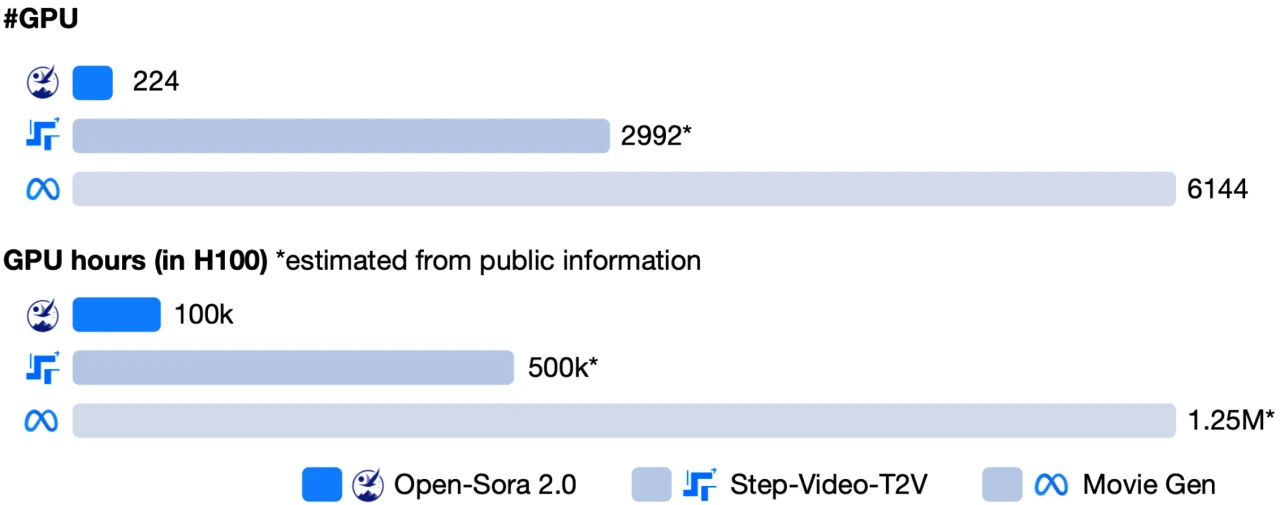

Open-Sora 2.0是由潞晨科技推出的一款全新开源的SOTA视频生成ai模型。它仅用20万美元(224张GPU)就成功训练出商业级11B参数视频生成大模型,实现接近 SOTA(最优)质量,但性能直追HunyuanVideo和 阶跃星程30B参数的Step-Video,接近 OpenAI Sora!Open-Sora 2.0具备高效训练和推理优化,能够快速生成 720p 分辨率的流畅视频,适用于创意视频制作、社交媒体内容生成等领域。

Open-Sora 2.0功能特征

高质量视频生成:支持720p高分辨率和24FPS流畅视频生成,能够生成细节丰富、场景切换自然的视频。

动作幅度可控:可根据需求设定运动幅度,以更好地展现人物或场景的细腻动作。

高性能与低成本:

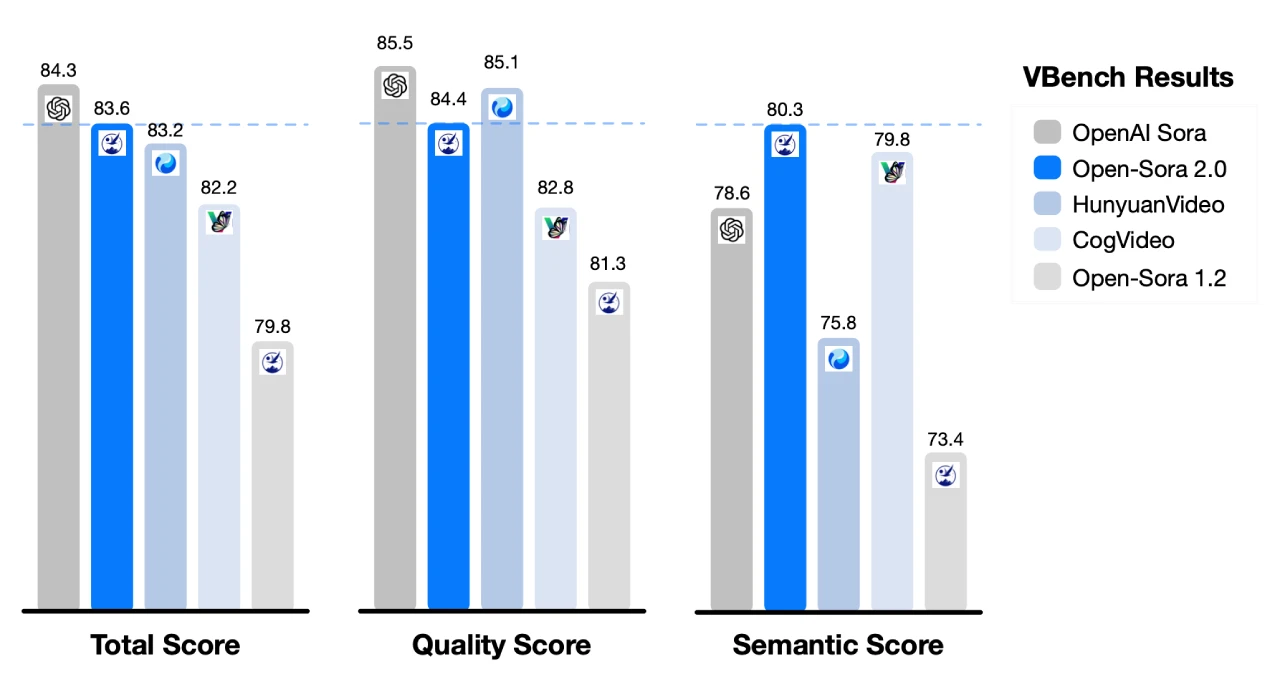

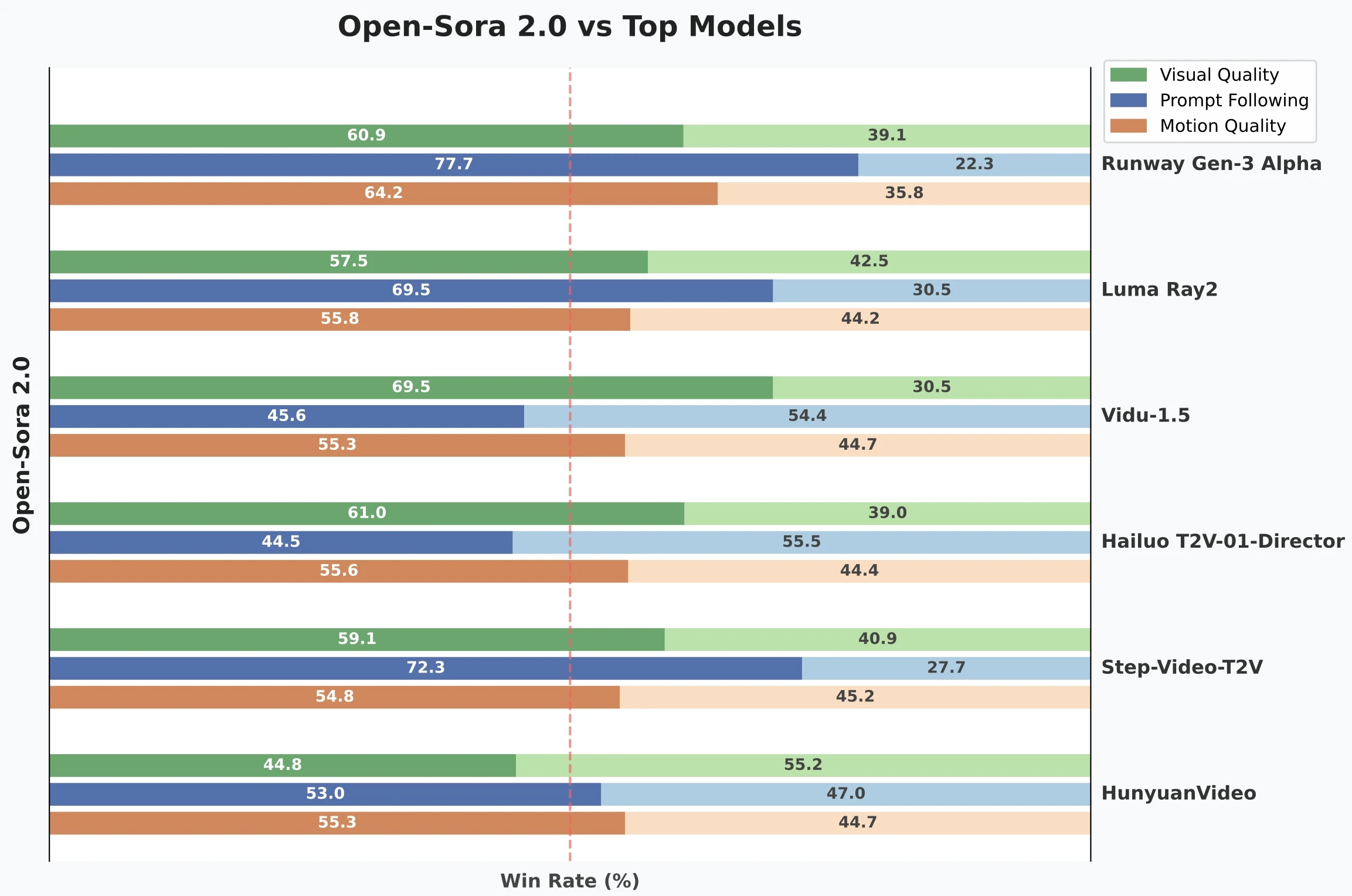

Open-Sora 2.0 采用 11B 参数规模,性能媲美甚至超越主流闭源大模型(如 HunyuanVideo 和 30B 参数的阶跃星程),在 VBench 和人工偏好测试中表现卓越。

训练成本大幅降低,仅用 20 万美元(224 张 GPU)即可完成训练,相比传统高性能视频生成模型,成本降低了 5-10 倍。,媲美 OpenAI Sora。

多种生成方式:

高效训练与优化:

采用多阶段、多层次的数据筛选机制,确保高质量数据输入,提升训练效率。

优先在低分辨率下训练,学习关键动态特征,逐步提升分辨率,大幅降低计算开销。

优先训练图生视频任务,用图像特征引导视频生成,加速模型收敛。

结合ColossalAI和系统级优化,提升计算资源利用率。

引入高压缩比视频自编码器,将推理时间缩短至单卡3分钟以内,推理速度提高了10倍。

强大的模型架构:

基于3D自编码器、3D全注意力机制和MMDiT架构,显著提升训练效率和推理速度。

通过多桶训练机制,实现对不同视频长度和分辨率的同时训练。

Open-Sora 2.0技术突破

模型架构:采用3D全注意力机制和MMDiT架构,增强时空特征建模能力;基于扩散Transformer(DiT)扩展,引入时间注意力层,实现视频序列的动态生成。

高效训练策略:通过多级过滤机制确保高质量训练数据输入,优先学习运动特征,再通过图生视频(T2I2V)提升画质,节省40倍计算资源。

推理加速革命:采用高压缩自编码器(4×32×32压缩比),将768px视频生成时间从30分钟缩短至3分钟,速度提升10倍。

Open-Sora 2.0应用场景

创意视频制作:可用于制作科幻短片、动画短片等,满足创意视频制作和内容生成的需求。

社交媒体内容生成:能够生成适合社交媒体分享的高质量视频内容。

游戏视频制作:为游戏视频的制作提供便利。

GitHub开源仓库:https://github.com/hpcaitech/Open-Sora

技术报告:https://github.com/hpcaitech/Open-Sora-Demo/blob/main/paper/Open_Sora_2_tech_report.pdf

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统