MoshiVis:一款能听还能看,并用流畅的语音跟你讨论图像内容的视觉语音模型

MoshiVis是什么?

MoshiVis 是一个在Moshi基础上开发的一款视觉语音模型,并保持了Moshi的低延迟和自然对话能力,能够以自然对话风格讨论图像内容。支持多轮对话,可以描述图片的文字内容并回答有关于图片的问题。

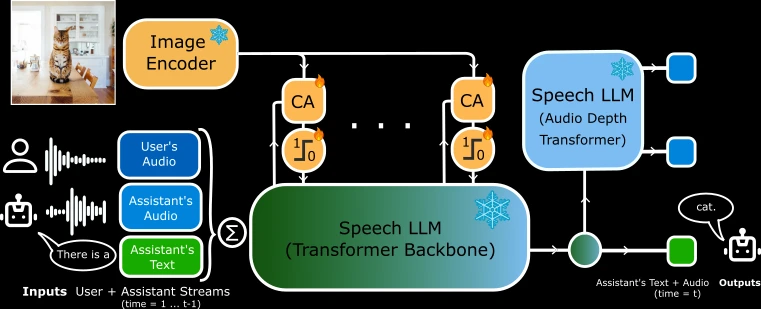

它通过交叉注意力机制将视觉信息融入语音流,同时保持低延迟和低内存占用。MoshiVis 提供了多种后端支持(如 PyTorch、Rust、MLX),并发布了预训练模型和合成视觉对话数据集,适用于实时语音交互场景。

MoshiVis核心功能

视觉与语音结合:MoshiVis 在 Moshi 的基础上增加了视觉理解能力,能够将图像信息融入语音对话中。通过扩展核心 Transformer 架构,引入交叉注意力机制,将视觉信息注入语音流中。

低延迟与低内存占用:为了保持低延迟并减少内存使用,MoshiVis 的交叉注意力投影权重在各层之间共享,并通过门控机制调节视觉输入流。

自然对话风格:模型在融入视觉能力的同时,保留了 Moshi 原有的自然对话风格。

MoshiVis技术架构

基础模型:基于 Moshi,一个 7B 参数的语音-文本基础模型。

视觉编码器:使用 PaliGemma2 家族的预训练冻结 400M 视觉编码器。

适配器参数:在 Moshi 基础上增加了约 206M 的适配器参数,用于视觉信息的处理。

交叉注意力机制:通过交叉注意力模块将视觉信息注入语音流,同时通过门控机制调节视觉输入的影响。

MoshiVis模型发布

模型变体:发布了基于 Moshika(女声)的 MoshiVis 模型,包含完整的模型权重,包括语音编解码器、文本分词器、图像编码器和基础 Moshi 模型。

后端支持:提供了三种后端支持,包括 PyTorch、Rust 和 MLX,支持不同的量化格式(如 BF16、Q8_0 等)。

许可证:模型权重(不包括视觉编码器)在 CC-BY 4.0 许可下发布,视觉编码器在 Gemma 许可下发布。

MoshiVis使用方式

WebUI 前端:提供了 WebUI 前端,支持回声消除,提升模型表现。用户可以通过预构建的静态版本或自行编译源代码来使用。

后端运行:

PyTorch:需要约 24GB GPU 内存,不支持量化。

Rust:支持 GPU 加速,需要 Rust 工具链和 CUDA(或 macOS 上的 Metal)。

MLX:支持 bfloat16 和量化(q4、q8)格式。

运行命令:提供了详细的运行命令,用户可以根据需要选择不同的后端和量化格式。

相关链接:

GitHub项目:https://github.com/kyutai-labs/moshivis

HuggingFace模型:https://huggingface.co/collections/kyutai/moshivis-v01-67cef4acae6a5d75d6d6c883

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统