Embodied-Reasoner:浙江大学和阿里巴巴达摩院等机构联合提出的一个开源的多模态具身模型

Embodied-Reasoner是什么?

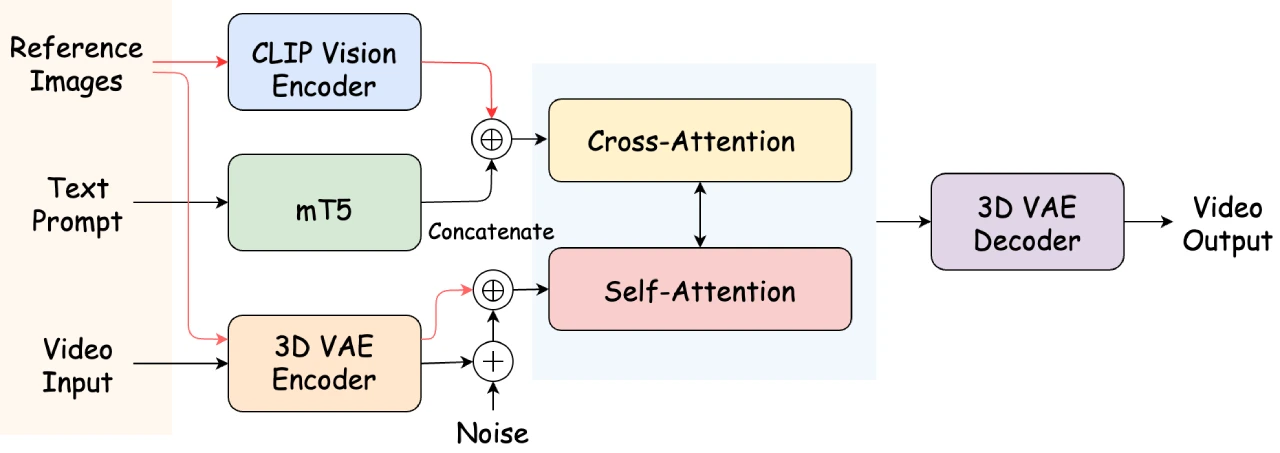

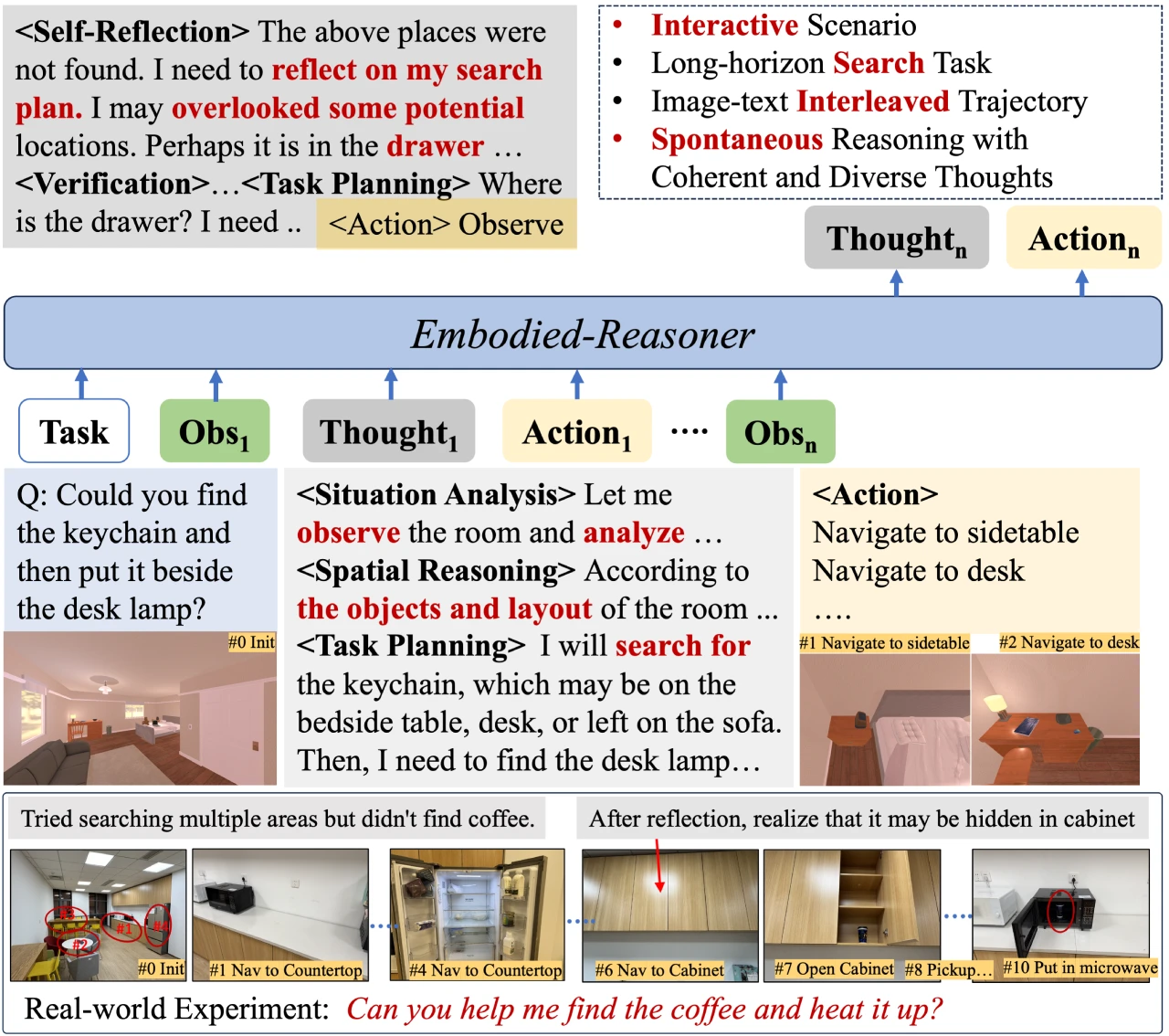

Embodied-Reasoner是由中科院软件所、浙江大学和阿里巴巴达摩院等机构联合提出的一个开源的多模态具身模型,它可以将深度推理能力扩展到具身交互任务中。能够处理复杂的具身任务,例如在 ai2-THOR 模拟器中搜索隐藏物体、操纵和运输物品等。

Embodied-Reasoner核心特点

深度推理能力:具备分析、空间推理、反思、规划等多种推理能力。

多模态交互处理能力:能够处理长序列的图像-文本交互上下文。

环境交互能力:可以自主观察环境、探索房间并找到隐藏物体。

开源模型和数据集:

提供 7B 和 2B 两种大小的开源模型。

数据集包含 9.3k 交互式的观察-推理-行动轨迹,涵盖 64K 图像和 8M 思考标记。

Embodied-Reasoner技术亮点

任务和轨迹引擎:自动合成连贯的“观察-思考-行动”轨迹,覆盖 107 种多样化的室内场景,如厨房和客厅,涉及 2,100 个交互对象和 2,600 个容器。

长链思考与多样化思考模式:包括分析、空间推理、反思、规划和验证等,这些连贯的图像-文本交错轨迹增强了其空间和时间推理能力。

迭代训练流程:结合模仿学习、自我探索调整和自我修正调整的三阶段迭代训练流程。

交互式评估框架:包含 809 个测试用例,覆盖 12 种新颖场景,评估模型在指令理解、关键动作和最终状态方面的表现。

Embodied-Reasoner性能表现

成功率(Success Rate):衡量任务是否成功完成。

搜索效率(Search Efficiency):评估任务效率,步骤越多效率越低。

任务完整性(Task Completeness):计算预测动作中属于关键动作的比例。

Embodied-Reasoner应用案例

模拟器实验:Embodied-Reasoner 展现出自发的思考行为,例如分析环境状态、反思遗漏细节、基于最新观察进行推理以及回忆线索进行高效规划。相比之下,缺乏思考能力的通用 VLM 在长时域交互任务中表现不佳,容易忘记任务或重复搜索。

真实世界实验:在真实环境中,Embodied-Reasoner 能够排除干扰,最终找到目标物体并完成任务,而 OpenAI 的 o3-mini 模型则无法制定合理计划。

Embodied-Reasoner使用指南

训练

1. 安装依赖:

conda create -n llama-factory python=3.11 conda activate llama-factory git clone -b embodied-reasoner https://github.com/iGangao/LLaMA-Factory.git cd LLaMA-Factory pip install -e ".[torch,metrics]" pip install wandb accelerate deepspeed importlib-metadata

2. 数据准备:参考 data/README.md 文件了解数据集文件的格式。

3. 运行训练脚本:运行训练脚本。

评估

1. 安装依赖:

conda create -n embodied-reasoner python=3.9 conda activate embodied-reasoner pip install -r requirements.txt

2. 运行评估脚本:运行评估脚本。

数据引擎

TaskGenerate.py:合成任务模板和对应的关键动作。

o1StyleGenerate.py和 o1StyleGenerate_ordered.py:分别为 10 种不同子任务类型合成轨迹,后者用于合成更复杂的顺序对象转移任务。

相关链接

GitHub项目主页:https://github.com/zwq2018/embodied_reasoner

Hugging Face 数据集:https://huggingface.co/datasets/embodied_reasoner

Arxiv 论文:https://arxiv.org/abs/2503.21696

Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统

提交您的产品

提交您的产品