Llama 4 Scout和Maverick有什么区别?

2025 年 4 月 5 日,Meta 发布了最新一代开源ai模型Llama 4,其中包括 Llama 4 Scout 和 Llama 4 Maverick。这两款AI模型都是首批采用混合专家(MoE)架构的多模态模型,他们有什么区别呢?

Llama 4 Scout 和 Llama 4 Maverick 的主要区别:

Llama 4 Scout

参数规模:170 亿个活跃参数,16 个“专家”模型,总参数量为 1090 亿。

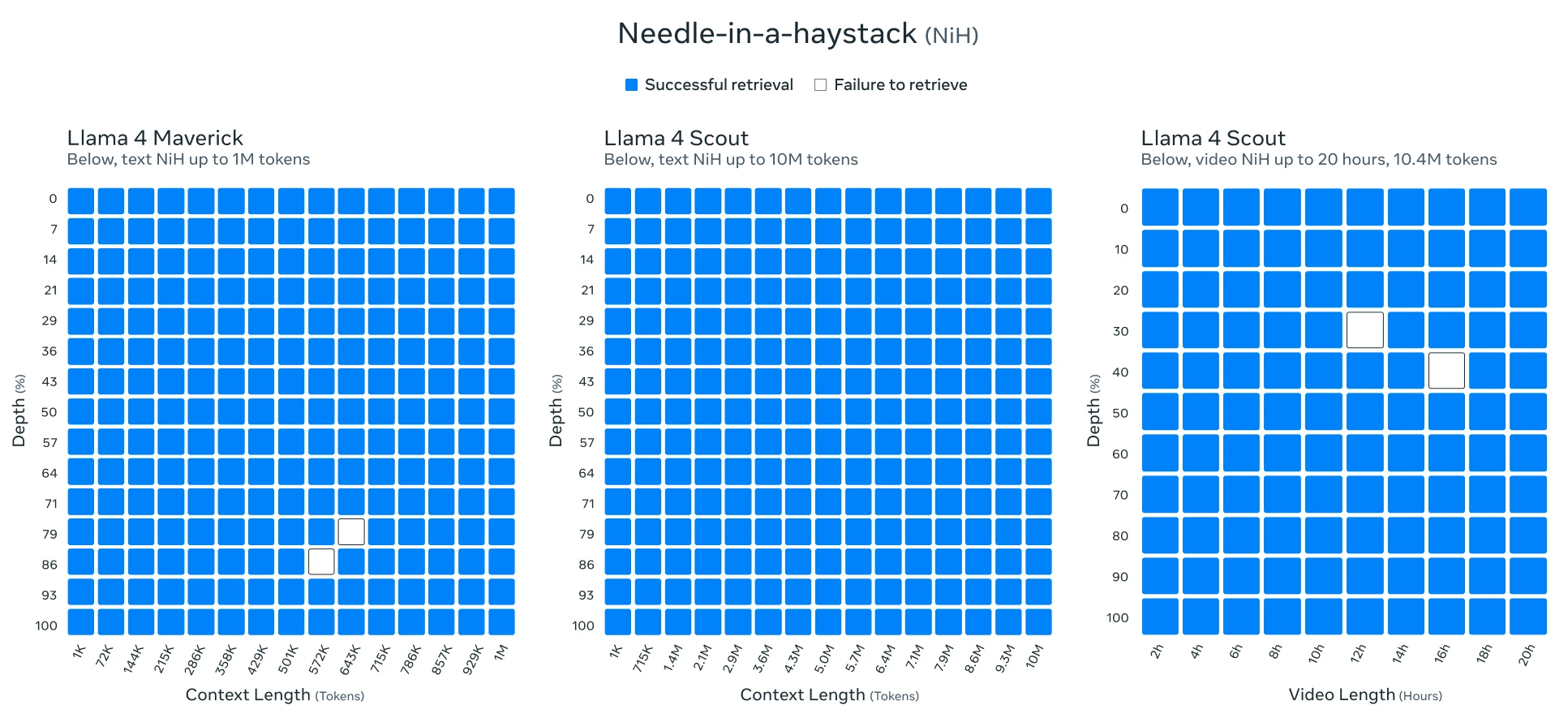

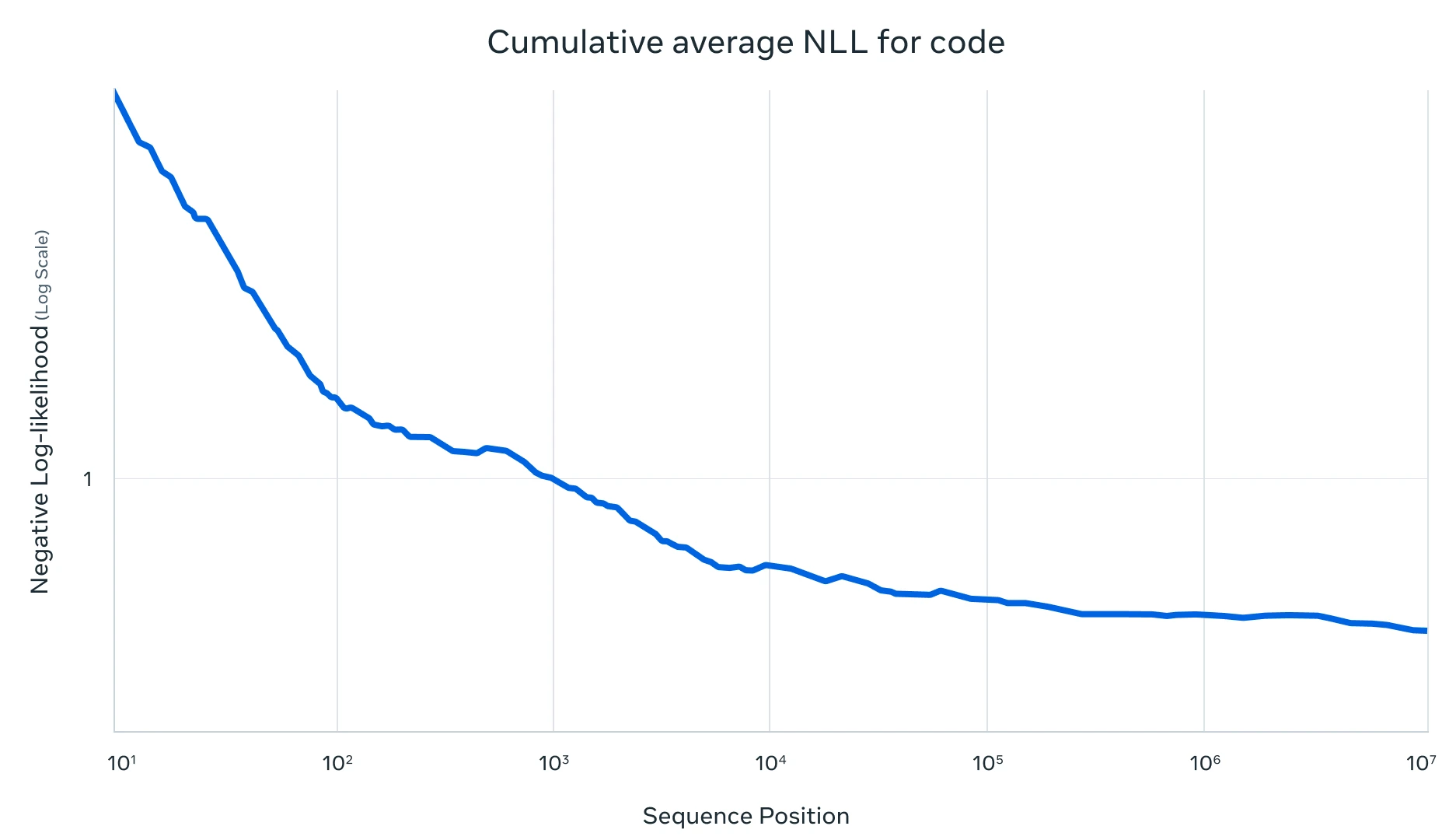

上下文窗口:支持高达 1000 万个 token 的上下文窗口,这使得它在处理冗长文档时表现尤为优异。

应用场景:擅长文档摘要和基于大型代码库的推理,适合需要高效推理和长文本处理的场景。

硬件需求:可以在单个 NVIDIA H100 GPU 上运行,通过 Int4 量化后,资源需求较低。

Llama 4 Maverick

参数规模:170 亿个活跃参数,128 个“专家”模型,总参数量高达 4000 亿。

上下文窗口:支持 100 万个 token 的上下文窗口。

应用场景:在创意写作、代码生成、翻译、推理、长文本上下文总结和图像基准测试中表现超过了 OpenAI 的 GPT-4o 和谷歌的 Gemini 2.0 等模型。

硬件需求:需要在 NVIDIA H100 DGX 主机或同等性能的设备上运行。

两者比较

性能:Maverick 在多模态任务和推理能力上表现更强,而 Scout 在长文本处理和文档摘要方面更具优势。

资源需求:Scout 更适合资源受限的场景,因为它可以在单个 GPU 上运行;Maverick 则需要更高的硬件配置。

应用场景:Scout 适用于需要处理大量文本的场景,如文档处理和代码推理;Maverick 更适合需要多模态交互和复杂推理的任务,如创意写作和图像处理。

推理成本

Llama 4 Scout:由于其较小的模型规模和高效的量化技术,推理成本相对较低,适合需要快速响应和低资源消耗的应用。

Llama 4 Maverick:虽然其总参数量更大,但由于采用了混合专家架构,其推理成本也得到了优化。Meta 估计,Llama 4 Maverick 的推理成本为每 100 万个 tokens 0.19 美元至 0.49 美元(输入和输出比例为 3:1),这使得它比像 GPT-4o 这样的专有模型便宜得多。

Llama 4 Scout 更适合需要处理长文本和资源受限的场景,而 Llama 4 Maverick 则在推理和代码生成能力上表现出色,适合需要高性能和多模态处理的应用。两者都通过混合专家架构实现了高效的资源利用,但具体的资源需求和成本取决于你自身的应用场景和硬件。

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统