OmniTalker:阿里推出的一款实时文本驱动的说话头像多模态生成框架多模态框架

OmniTalker 是什么?

OmniTalker是阿里巴巴通义实验室研发的一款实时文本驱动的说话头像ai多模态生成框架。它可以根据输入的文本内容,实时生成与之匹配的语音和视频动画。生成的语音和视频不仅高质量,还能逼真地模拟面部表情和头部动作,仿佛是一个真实的“数字人”在与你对话。OmniTalker支持中英文互转,支持情感表达,比如平静、快乐、悲伤、愤怒等等情绪并支持长视频生成。

OmniTalker功能特点

多模态输入处理:能够感知文本、图像、音频和视频等多种模态。

流式生成:以流式方式生成文本和自然语音响应,音频和视频编码器采用按块处理方法,解耦了对长序列多模态数据的处理。

音视频精准同步:通过 TMRoPE 技术,确保视频与音频输入的精准同步。

实时交互:支持分块输入和即时输出,能够进行完全实时交互。

语音生成自然流畅:在语音生成的自然性和稳定性方面表现优异,超越了许多现有的流式和非流式替代方案。

性能优势:在多模态基准测试中表现出色,音频能力优于类似大小的 Qwen2-Audio,并与 Qwen2.5-VL-7B 保持同等水平。

OmniTalker核心技术

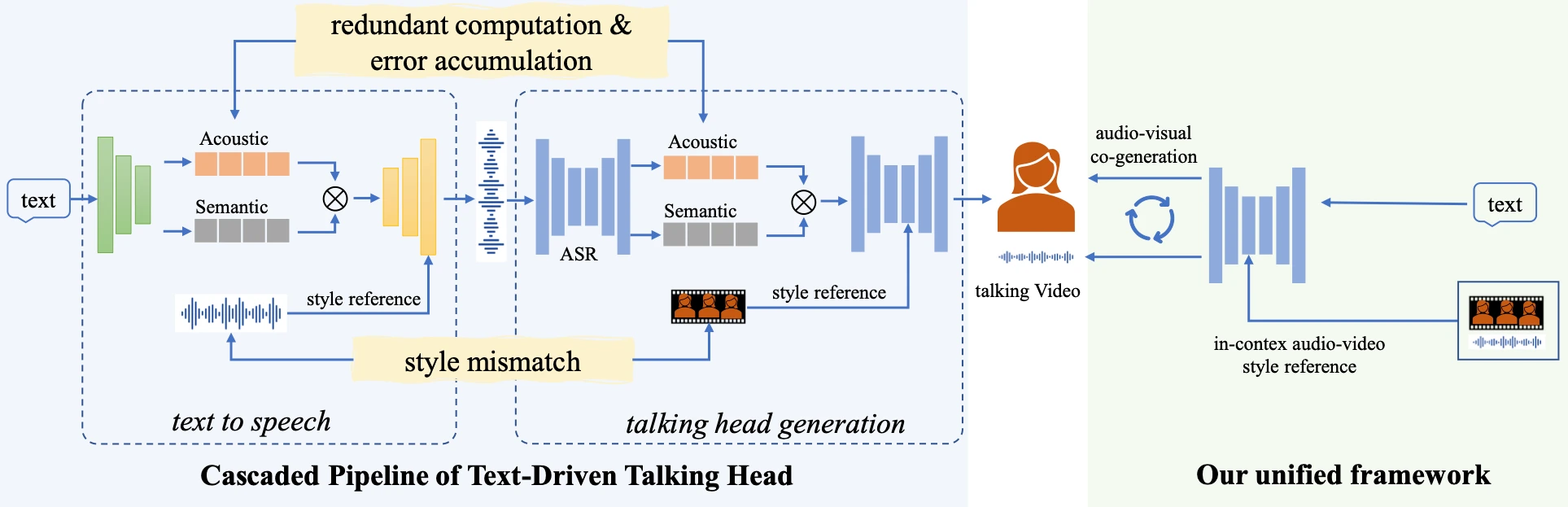

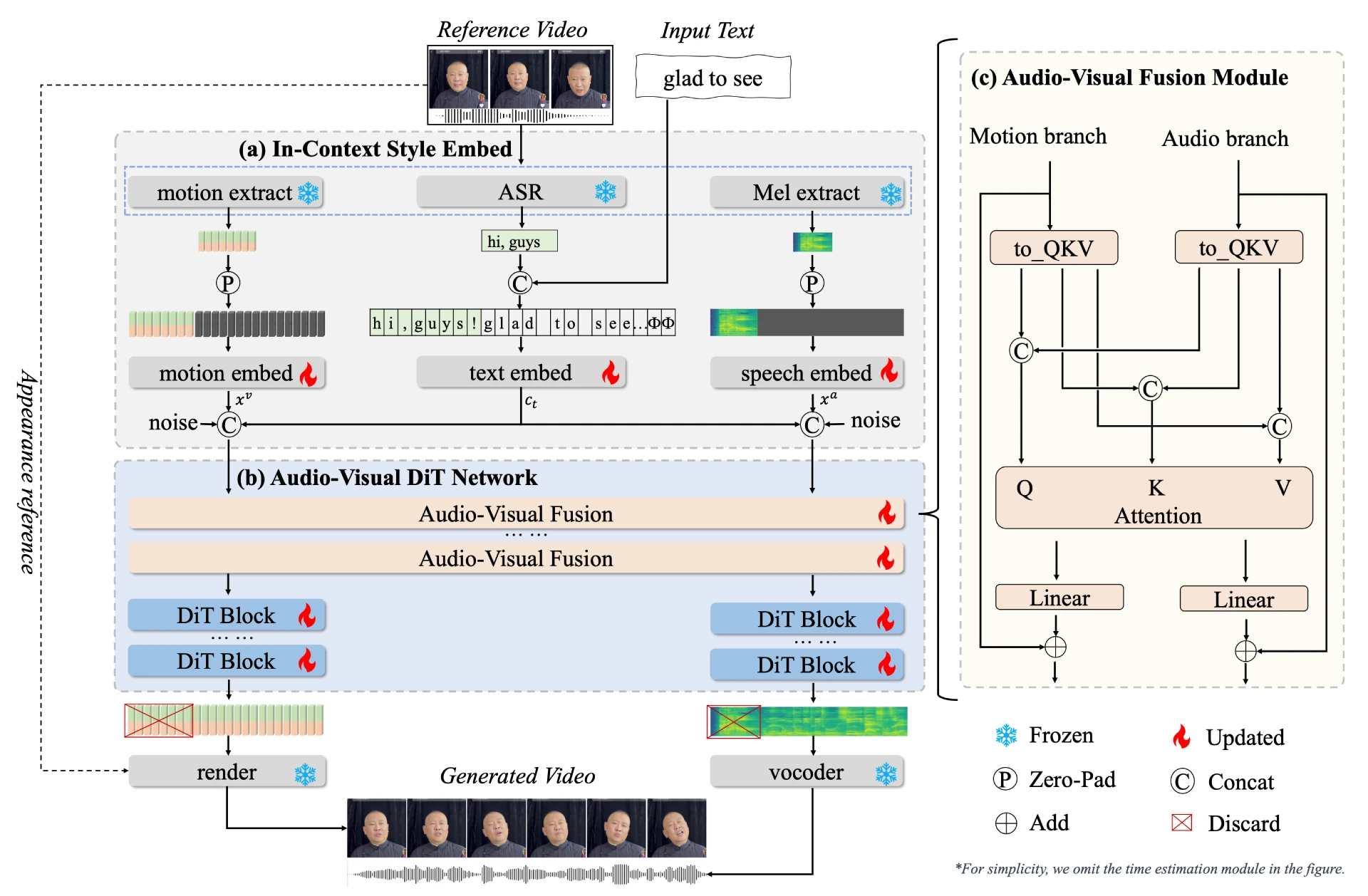

1. 双分支扩散变换器(DiT)架构

包含 音频分支 和 视觉分支:

音频分支:从文本中合成高质量的语音。

视觉分支:预测头部姿势和面部动态。

通过一个新颖的 音频-视觉融合模块,确保音频和视频输出在时间上的同步性和风格上的一致性。

2. 上下文参考学习

OmniTalker 能够从单个参考视频中捕获语音和面部风格特征,无需额外的风格提取模块。这意味着,无论输入的文本是什么,OmniTalker 都能够生成与参考视频风格高度一致的语音和视频内容。

3. 实时性与高效性

OmniTalker 能够以 25 FPS 的速度实时生成语音和视频,这在同类技术中是非常领先的。这种高效的推理速度使得 OmniTalker 可以应用于实时视频聊天、虚拟直播等场景,为用户带来流畅的交互体验。

OmniTalker应用场景

智能语音助手:处理用户的语音指令,实时生成语音回应。

多模态内容创作:同时处理文本、图像和视频输入,生成相应的文本或语音描述。

教育与培训:生成虚拟教师,根据教学内容生成语音和视频。

虚拟客服与助手:创建虚拟客服或助手,实时生成语音和视频回应。

娱乐与媒体:创建虚拟主播、演员,实时生成表演内容。

OmniTalker优势

高质量生成:生成的语音和视频内容质量高,能精准复制参考视频的风格,包括语音语调、节奏和面部表情的细微变化。

零样本学习:无需大量训练数据,可根据输入文本和参考视频快速生成内容,适应不同场景和需求。

实时交互:以25 FPS的速度实时生成语音和视频,延迟低,适用于实时视频聊天、虚拟直播等场景。

项目官网:https://humanaigc.github.io/omnitalker/

技术论文:https://arxiv.org/pdf/2504.02433v1

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统