langchain推出mcpdoc:通过解析llms.txt文件提取信息,解决信息过载不准确问题

MCPdoc是什么?

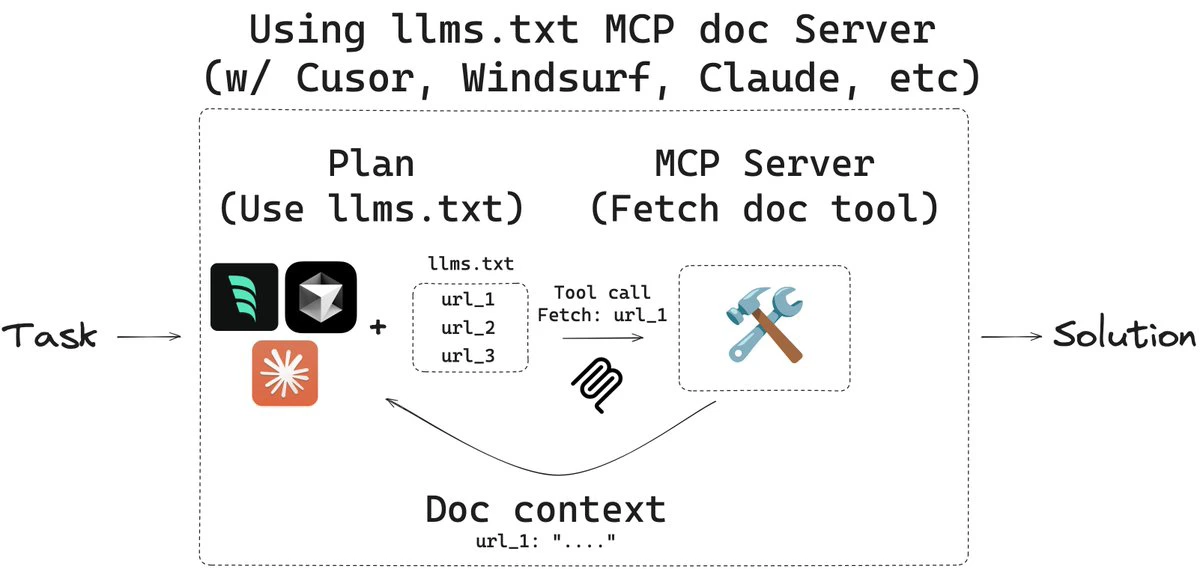

mcpdoc 是 LangChain 推出的一个可以通过 MCP服务器,将 llms.txt 文件的内容以编程开发工具的形式暴露给集成开发环境或其他应用程序,解决信息过载/不完整/不准确的问题,帮Ai助手理解复杂的框架文档,为开发者提供更高效、更透明的开发体验。

mcpdoc原理

mcpdoc 的核心是 MCP 服务器,它负责索引和管理 LLMs 的配置信息,并向 IDE 和其他应用程序提供上下文数据。应用程序根据当前开发环境和代码上下文,通过 API 调用向 MCP 服务器请求相关的 LLM 配置信息。

mcpdoc核心功能

提供 llms.txt 文件的访问接口:llms.txt 是一个为 LLMs(Large Language Models,大型语言模型)提供上下文信息的文件,它包含了背景信息、指导内容以及指向详细文档的链接。mcpdoc 通过 MCP 服务器,将这些信息以标准化的方式提供给 IDEs 或其他应用程序。

支持多种文档来源:用户可以通过多种方式指定 llms.txt 文件的来源,包括直接指定 URL、使用 YAML 配置文件或 JSON 配置文件。

增强开发工具的上下文理解能力:通过 MCP 服务器,IDEs 或其他应用程序可以动态获取和解析 llms.txt 文件中的内容,从而为开发者提供更丰富的上下文信息,帮助他们更好地理解和使用 LLMs。

审计和控制工具调用:与直接使用内置工具读取和处理 llms.txt 文件相比,mcpdoc 允许用户审计每次工具调用以及返回的上下文内容,从而提供更高的透明度和控制力。

mcpdoc应用场景

集成开发环境(IDEs):例如 Cursor、Windsurf 等 IDEs 可以通过 mcpdoc 提供的 MCP 服务器,动态获取 llms.txt 文件中的上下文信息,从而为开发者提供更智能的代码辅助功能。

AI 辅助开发工具:像 Claude Code/Desktop 等工具可以利用 mcpdoc 提供的上下文信息,为开发者提供更准确的代码建议和文档支持。

文档生成与管理:mcpdoc 可以帮助开发者自动生成和管理与代码相关的文档,减少手动编写和维护文档的工作量。

mcpdoc使用方法

安装

首先需要安装 uv 工具,可以通过以下命令安装:

curl -LsSf https://astral.sh/uv/install.sh | sh

启动 MCP 服务器

可以通过以下命令启动 mcpdoc 服务器,指定 llms.txt 文件的来源:

uvx --from mcpdoc mcpdoc \ --urls "LangGraph:https://langchain-ai.github.io/langgraph/llms.txt" "LangChain:https://python.langchain.com/llms.txt" \ --transport sse \ --port 8082 \ --host localhost

--urls 参数用于指定 llms.txt 文件的来源,可以指定多个 URL。

--transport 参数指定通信方式,例如 sse(Server-Sent Events)。

--port 和 --host 参数用于指定服务器的端口和主机地址。

Github项目:https://github.com/langchain-ai/mcpdoc

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统