LiveCC:字节跳动和新加坡国立大学合作开发的能实时解说的视频大语言模型

LiveCC是什么?

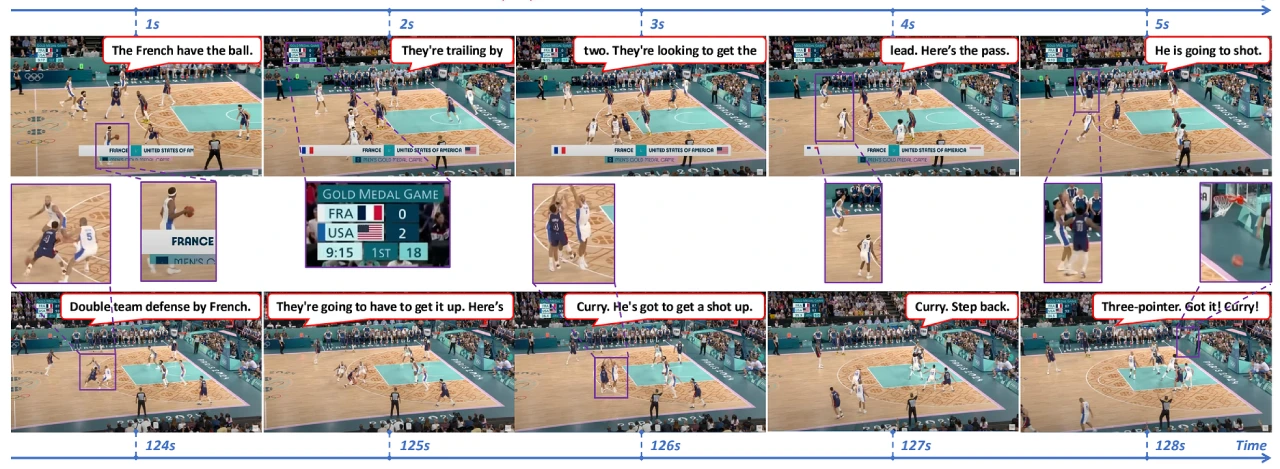

LiveCC是字节跳动和新加坡国立大学合作开发的视频大语言模型,能实时解说视频内容。它用自动语音识别(ASR)转录本训练,成本低,效率高。研究人员还开发了新的流训练方法和数据生产管道,构建了Live-CC-5M和Live-WhisperX-526K两个数据集。即使没有经过高质量监督微调,LiveCC-7B-Base模型在视频问答和实时解说上表现也很出色。经过LiveSports-3K基准测试评估,最终的LiveCC-7B-Instruct模型在实时解说质量上超过了72B的先进模型,在VideoMME和OVOBench等视频问答基准测试中也取得了顶尖成绩。

LiveCC核心特点

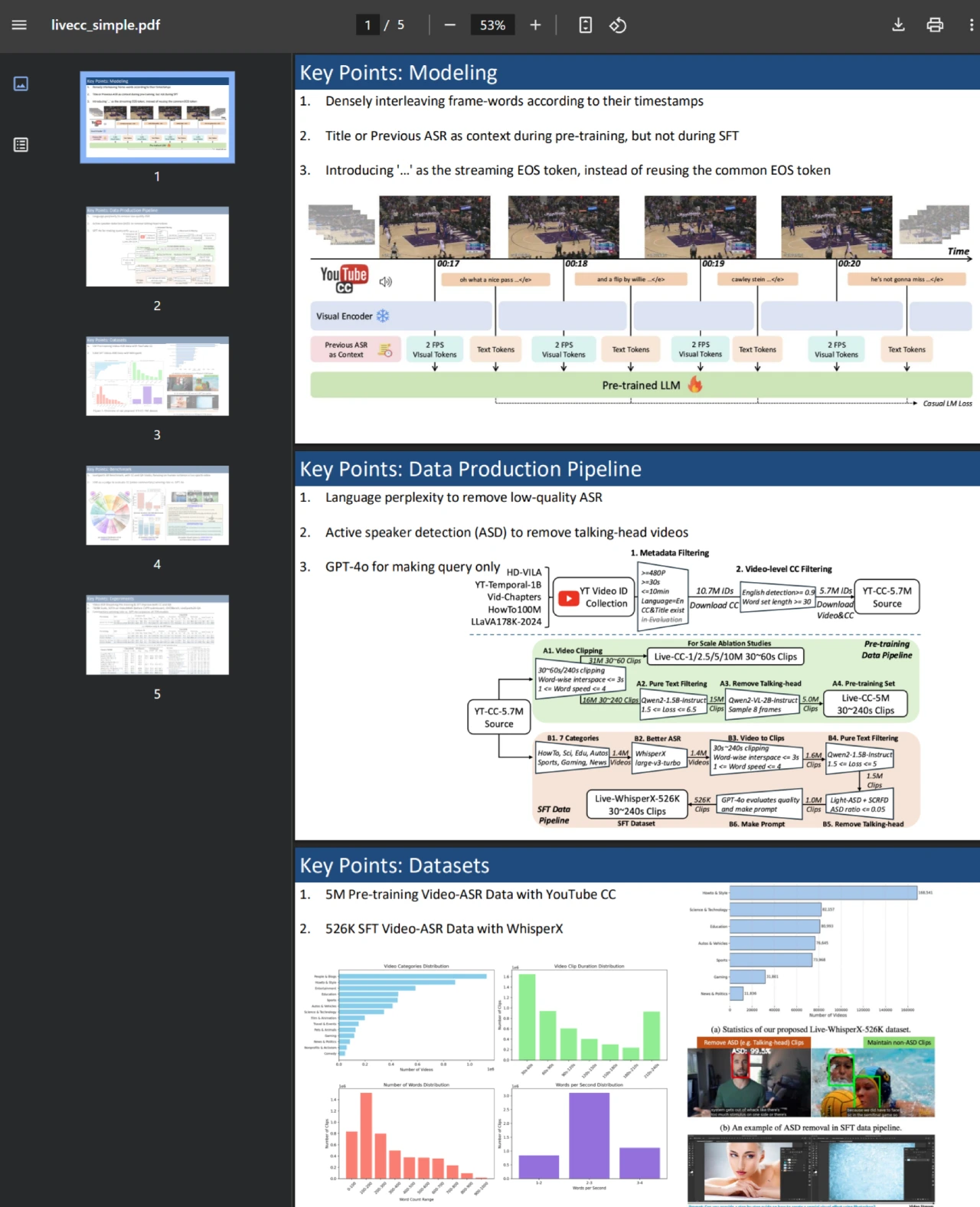

模型训练方法

创新训练方式:提出一种新颖的视频 - ASR 流训练方法,根据时间戳将 ASR 单词和视频帧紧密交织,符合 ASR 的流特性,使模型能学习时间对齐、细粒度的视觉语言建模。

数据生产与数据集构建:引入数据生产管道处理 YouTube 视频及其字幕(CC,等同于 ASR),构建了用于预训练的Live-CC-5M数据集和用于高质量监督微调(SFT)的Live-WhisperX-526K数据集。

模型性能

LiveCC-7B-Base 模型:即便未进行 SFT,该模型在通用视频问答任务中就展现出有竞争力的性能,还具备实时视频解说的新能力。

LiveCC-7B-Instruct 模型:通过精心设计的LiveSports-3K基准测试(使用 LLM 作为评判标准衡量自由形式解说)评估,该模型在实时模式下的解说质量超越先进的 72B 模型(如 Qwen2.5-VL-72B-Instruct、LLaVA-Video-72B)。在流行的视频问答基准测试(如 VideoMME 和 OVOBench)中,在 7B/8B 规模上取得了最先进的成果,证明了方法的广泛通用性。

LiveCC应用

LiveCC 可以广泛应用于视频内容的实时解读、体育赛事的实时评论、教育视频的互动讲解等领域。

常见问题

问:LiveCC 与其他视频大语言模型在训练数据获取上有什么不同?

答:LiveCC 利用廉价的自动语音识别(ASR)转录本进行大规模训练,而其他模型常依赖昂贵的人工注释或专有模型 API(如 GPT-4o),这种差异使LiveCC 在训练数据的成本和规模上更加有优势。

问:Live-CC-5M 和 Live-WhisperX-526K 数据集分别有什么作用?

答:Live-CC-5M 数据集用于模型的预训练,帮助模型学习通用的视觉语言特征和知识;Live-WhisperX-526K 数据集用于高质量监督微调(SFT),使模型在特定任务上表现更好,提升模型的性能。

问:LiveCC-7B-Instruct 模型在实时解说方面超越 72B 模型有什么意义?

答:表明 LiveCC 的训练方法和模型架构有效,能够在较低参数量下实现更高效的实时解说功能,这为视频大语言模型在实时应用场景(如体育赛事直播解说等)的推广提供了更具性价比的解决方案。

相关链接

GitHub 仓库地址:https://github.com/showlab/livecc

Releases 页面:https://github.com/showlab/livecc/releases

项目主页:https://showlab.github.io/livecc/

论文链接:https://arxiv.org/abs/2504.06885

在线演示:https://huggingface.co/spaces/chenjoya/LiveCC

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统