InspireMusic

InspireMusic简介

InspireMusic是由阿里巴巴通义实验室推出的开源音乐生成框架,其技术架构集成了多项音频领域前沿研究成果,为开发者和研究者提供音乐创作、风格转换及音效合成的全流程解决方案。该框架依托多模态大模型技术,支持通过文本描述或音频输入进行智能化创作,同时提供完善的模型调优工具链。

InspireMusic的文生音乐创作模式非常强。它支持通过文字描述生成各种风格和情感的音乐,用户可以根据个人喜好生成爵士乐或旋律悠扬的童谣等多样化作品。

InspireMusic核心功能:

音乐生成:InspireMusic可以基于用户提供的文本描述,例如情感、风格、和声等信息,自动生成符合要求的音乐作品。

音频样式转换:该技术支持将现有音频样本转换为不同风格的音乐,使用户可以轻松实现风格转换的效果。

训练和调优工具:InspireMusic为开发者提供了一系列音频生成模型的训练和调优工具,以优化生成效果,满足个性化需求。

多模态应用:通过结合文本、音频及其交互,InspireMusic能够提供丰富的音乐创作体验,支持多种类型的音乐生成与编辑功能。

主要特点

统一的音频生成框架:基于音频大模型技术,InspireMusic支持音乐、歌曲及音频的生成,为用户提供多样化选择;

灵活可控生成:基于文本提示和音乐特征描述,用户可精准控制生成音乐的风格和结构;

简单易用:简便的模型微调和推理工具,为用户提供高效的训练与调优工具。

InspireMusic主要技术原理:

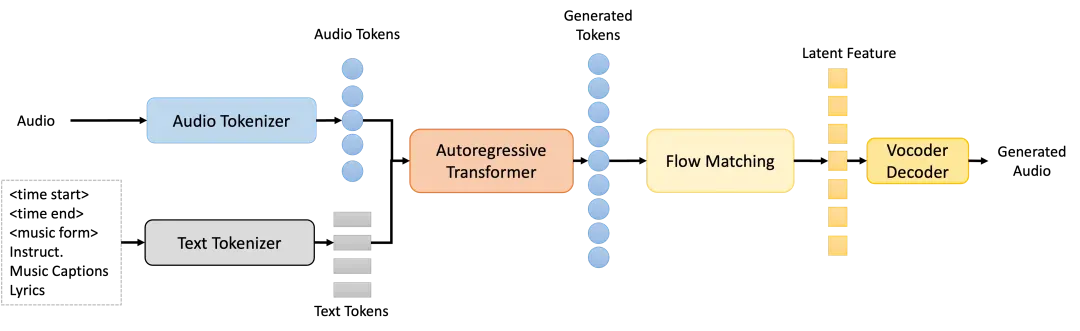

音频Tokenizer:通过高压缩比的单码本WavTokenizer,将输入的连续音频特征转换为离散的音频token,支持模型处理的音频数据格式。

自回归Transformer模型:该模型基于Qwen模型进行初始化,用于根据文本提示预测音频token,能够理解并生成与文本描述匹配的音乐序列。

扩散模型(Conditional Flow Matching, CFM):用于从生成的音频token中恢复高质量音频特征,增强音乐生成的连贯性和自然度。

Vocoder:将重建后的音频特征转换为高质量的音频波形,最终输出音乐作品。它支持多种采样率(如24kHz和48kHz),并能够生成超过5分钟的长音频作品。

核心模型:

InspireMusic模型框架:由音频tokenizer、自回归Transformer模型、基于常微分方程的扩散模型即Conditional Flow Matching (CFM)模型、Vocoder所组成,可支持文本生成音乐、音乐续写等任务。

InspireMusic的应用:

音乐创作:用户通过简单的文字描述或音频提示生成多种风格的音乐作品。

教育和学习:该工具包为音乐爱好者和学习者提供了一个易于使用的创作平台。

游戏和娱乐:InspireMusic可以用于生成游戏背景音乐或音效。

影视制作:用于影视配乐和音效制作。

广告和营销:InspireMusic可以生成符合广告需求的音乐。

科研和开发:为研究者和开发者提供音乐生成模型的训练和调优工具。

使用方式:

近日,阿里通义实验室宣布旗下音乐生成技术InspireMusic已正式开源。用户可以通过GitHub仓库、ModelScope创空间以及HuggingFace Spaces等平台访问和使用InspireMusic。

GitHub 仓库:https://github.com/FunAudioLLM/InspireMusic

ModelScope:https://modelscope.cn/studios/iic/InspireMusic/summary

HuggingFace:https://huggingface.co/spaces/FunAudioLLM/InspireMusic

提交您的产品

提交您的产品  Ai应用

Ai应用 Ai资讯

Ai资讯 AI生图

AI生图 AI生视频

AI生视频 AI生PPT

AI生PPT AI数字人系统

AI数字人系统